![[FramePack] 入門講座 #08:(番外編)CLIでFramePackを動作させ画像を一括変換する](https://humanxai.info/images/uploads/framepack-practice-08.webp)

はじめに

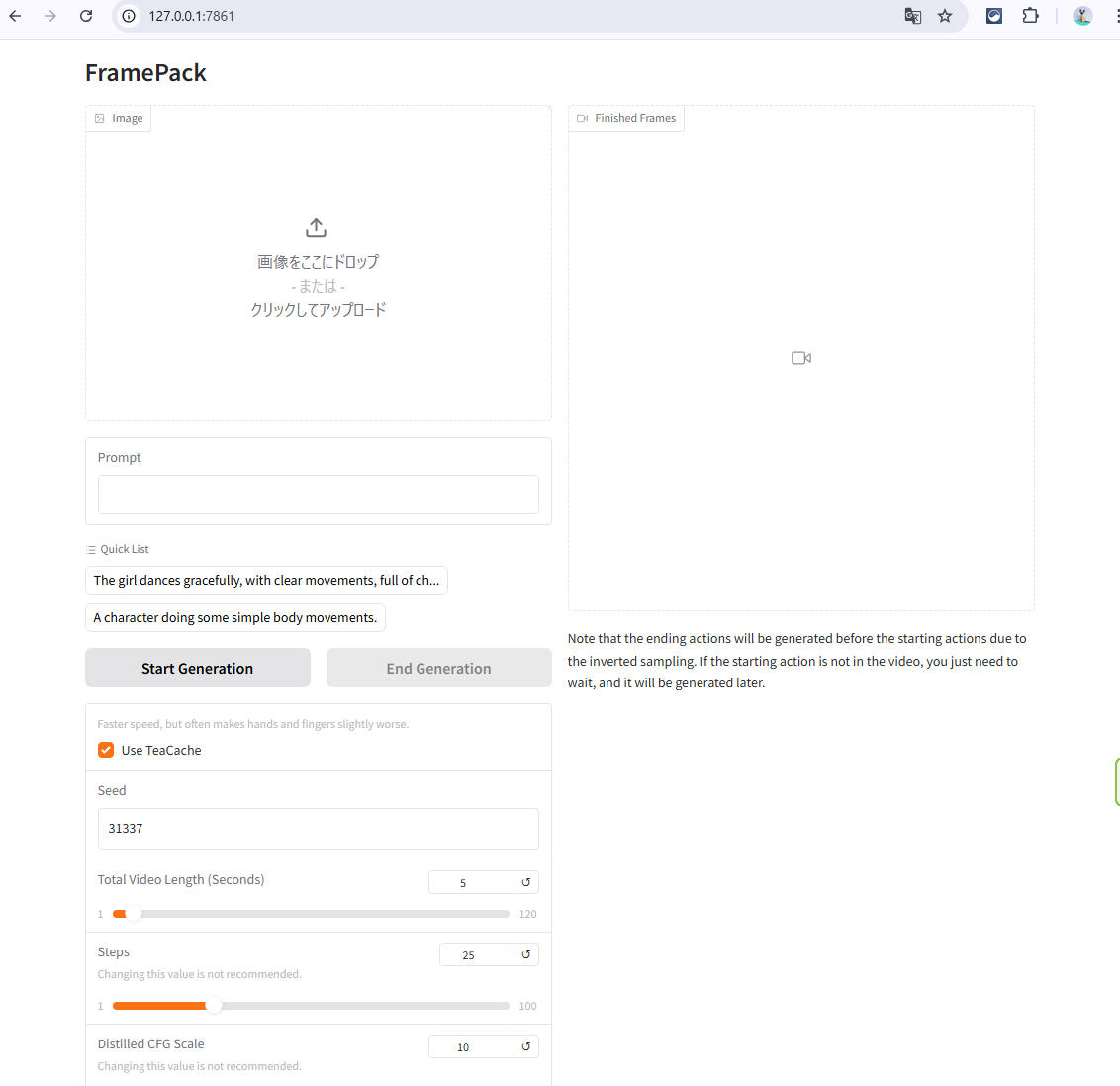

FramePackを活用しはじめた初期の頃、コマンドラインで特定フォルダの画像を一括変換出来きないかと考えていたのですが、本講座の最終章としてそれにチャレンジしてみます。

ネット上には、FramePackをCLIで動作させる報告例は、Qiitaで1つ見かけたぐらいで殆どなく、かなり実験的な試みになると思います。 上手く行くかどうかわかりませんが、失敗したのしても、情報は誰かの役に立つかもしれませんのでそのまま公開します。

使用環境

- Windows / WSL / Linux

- Python 3.8+

- FramePack cu126 torch26(手動インストール済)

実行コマンドの基本形

python endframe_ichi.py --input_dir ./img01 --prompt "キャラが手を振る"

AIとの対話

あと1つ残ってる課題が、

FramePack × AIアニメーション 入門講座

#08 番外編:CLIでFramePackを動作させ画像を一括変換する

ですね…。

ラストの #08 番外編:「CLIでFramePackを動かす」 ですね。

これはFramePackの「裏モード」的な立ち位置で、中~上級者向けの内容になりますが、既にここまで到達しているあなたにはピッタリの締めくくりです。

🧩 何が難しいのか?

ドキュメントがほぼ存在しない

GUIと違って「どのオプションを何に使うか」が見えない

内部構成が日々変わっており、run.batやendframe_ichi.pyなどのバッチやPythonスクリプトを読む必要あり

✅ おすすめの進め方(2ステップ構成)

🔹 Step1:最小構成で動作確認

WebUI不要で endframe_ichi.py などを単体実行

CLIで画像→動画が1本生成できるかを試す(テンプレ画像でOK)

🔹 Step2:一括処理スクリプト作成

指定フォルダ内の複数セット(Image1〜Image4)を順に動画化

実行結果(mp4)を自動で保存し、ログを表示

初期ステップの進め方

Step 1:まずは静止画1枚 → CLIで動画生成

endframe_ichi.py などのPythonスクリプトを直接実行

必要な最低限の画像(Image1.png〜Image4.png)を用意

prompt や section count はスクリプト内 or 引数で指定(どちらも試す)

ディレクトリ構成(例)

/framepack_cli_test/

├── Image1.png

├── Image2.png

├── Image3.png

├── Image4.png

実行コマンド(仮)

python endframe_ichi.py --input_dir ./framepack_cli_test --prompt "少女が手を振る"

※実際は demo_gradio.py や内部の webui/settings/*.yaml を参照しながら、必要なパラメータを整備する必要があるかもしれません。

PyYAMLをインストール

>python endframe_ichi.py --input_dir ./framepack_cli_test --prompt "少女が手を振る"

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\endframe_ichi.py", line 13, in <module>

import yaml

ModuleNotFoundError: No module named 'yaml'

>pip install pyyaml

Collecting pyyaml

Using cached PyYAML-6.0.2-cp310-cp310-win_amd64.whl.metadata (2.1 kB)

Using cached PyYAML-6.0.2-cp310-cp310-win_amd64.whl (161 kB)

Installing collected packages: pyyaml

Successfully installed pyyaml-6.0.2

- endframe_ichi.py の中身を確認し、必要な .yaml 設定ファイルの有無をチェック

- もし必要なら、最小構成の .yaml テンプレートを用意(初期値指定)

- 静止画1枚 → CLIで動画生成テスト

- 成功したら一括変換スクリプトに展開

- 失敗したらログを確認して対処

🔍 オプションで記事構成に落とし込む場合

- なぜWebUIではなくCLIを選んだか

- 環境構築でハマりやすい点

- yamlの書き方とFramePack CLIの仕様

- 自作バッチや自動化スクリプト紹介

>python endframe_ichi.py --input_dir ./framepack_cli_test --prompt "少女が手を振る"

usage: endframe_ichi.py [-h] [--share] [--server SERVER] [--port PORT] [--inbrowser] [--lang LANG]

endframe_ichi.py: error: unrecognized arguments: --input_dir ./framepack_cli_test --prompt 少女が手を振る

そもそもOPTION指定が間違ってるように見えます。

内部構造を調べる

>python endframe_ichi.py -h

usage: endframe_ichi.py [-h] [--share] [--server SERVER] [--port PORT] [--inbrowser] [--lang LANG]

options:

-h, --help show this help message and exit

--share

--server SERVER

--port PORT

--inbrowser

--lang LANG Language: ja, zh-tw, en

CLIでの利用はやっぱり厳しそうですね…。

詳細なログありがとうございます。

結論から言うと:

❌ endframe_ichi.py は CLI変換用のスクリプトではなかった ようです。

💡補足説明

あなたが試したこのコマンドは、「CLIから画像→動画をバッチ生成できる」想定だったのに、実際の endframe_ichi.py は Gradio UIの起動スクリプトのようです。

-h の結果を見ると、Gradio系でよくあるオプションが並んでいます:

- –share(外部アクセスURL)

- –inbrowser(ブラウザ起動)

- –lang(UIの言語)

これらは WebUI 起動専用スクリプトに多く、画像変換などの処理は内部の別スクリプト(あるいはモジュール)で実行していると思われます。

✅ 次のステップ案(CLI対応の可能性を探る)

- endframe_ichi.py を開いて、中身を確認

以下の点を探ります:

- gr.Interface(…) でGradioを起動している?

- main()やlaunch()でUI起動だけしてる?

- 処理部分(動画生成)はどこに記述されている?

- functions.py や utils.py のような内部モジュールを探す

webui/ ディレクトリ内に、変換処理を持ったファイルがある可能性が高いです。

探すキーワード:

- def predict( や def generate_movie(

- ffmpeg, imageio, torch, transform, load_model, inference, save_video など

他も検索しましたが、torchコマンドはファイル作成用によく使われてるぐらいですね…

✅ 主な内容

gr.Interface を使ってWeb UIを生成しています。

コマンドライン引数は –share, –port, –server, –lang などのGradio用オプションだけです。

main() 関数も launch() でUI起動するだけで、CLIから画像→動画変換を行う処理は含まれていません。

✅ どうすればCLIで使える?

もしFramePackでCLIから直接画像を動画に変換したいのであれば、以下の方法があります:

🛠 1. predict() 相当の処理を特定して分離

process() または generate_video() のような関数があるか確認。

それをスクリプトに移植し、main()内でファイルを一括処理できるように組み直す。

🔧 次に行うべき作業

以下のいずれかをお願いします:

framepack_core.py など他のファイル(UIの裏で実行される変換処理が含まれている)をアップロードいただく

または、gr.Interface(…) に渡されている関数名(例:inference)の実体を調べ、その関数を使ったCLIスクリプトを作成

必要であれば、こちらでCLI用の簡易ラッパースクリプトを作成しますので、内部処理を行っている関数定義ファイルを共有いただけると助かります。

あと、ほぼ同名の「demo_gradio_f1.py」もありますが、これが別バージョンをインストールした際に作成された物だと思います。

更に、demo_gradio.pyに関しては、FramePack-eichi用ではなく、FramePack用の可能性もありますが、今回は、動作せることを優先で、FramePack-eichiバージョンにはこだわりません。

demo_gradio.py -> worker()

✅ 現状まとめ

endframe_ichi.py は –input_dir や –prompt などのCLI引数を受け付けない → CLI実行は非対応。

代わりに demo_gradio.py は完全な動作ロジック(process() → worker())を含んでおり、Gradio UIを経由して動かす設計。

worker() 関数がコアの生成処理で、prompt・input_image などを受け取り動画生成。

つまり、

✳️ 現状では、直接CLIから画像とプロンプトを指定して動かす方法は存在していません

→ Gradio UI を経由して、ブラウザ上から対話形式で入力する設計になっている

✅ 今後できること

① Gradio UI ではなく、スクリプトで自動化実行したい場合

worker() 関数が主処理なので、それを呼び出すスタンドアロンの Python スクリプトを別途書けば、CLIからバッチ実行できます。

② 例えば、以下のような run_framepack.py を用意:

from demo_gradio import worker

from PIL import Image

import numpy as np

# 入力画像の読み込み(例: test.jpg)

input_image = np.array(Image.open("test.jpg").convert("RGB"))

# パラメータ指定

prompt = "少女が手を振る"

n_prompt = ""

seed = 1234

total_second_length = 5

latent_window_size = 9

steps = 25

cfg = 1.0

gs = 10.0

rs = 0.0

gpu_memory_preservation = 6

use_teacache = True

mp4_crf = 16

# 実行

worker(input_image, prompt, n_prompt, seed, total_second_length, latent_window_size,

steps, cfg, gs, rs, gpu_memory_preservation, use_teacache, mp4_crf)

これで python run_framepack.py などで、Gradio UI を使わず直接バッチ実行が可能です。

ただし、以下の点に注意:

AsyncStream が裏で必要(必要なら stream を適宜初期化)

generate_timestamp() により outputs/ に動画が保存される設計

結果の動画ファイルパスがコード内で明示されないため、stream.output_queue を読むなど追加が必要かも

結論

- 現行の endframe_ichi.py は CLI非対応

- 画像+プロンプトを直接渡してCLI動作させるには worker() を別スクリプトから呼び出す必要あり

- 本格的なCLI対応をするなら argparse 付きラッパースクリプトの作成がおすすめです

>\framepack_cu126_torch26\webui\demo_gradio.py

このファイルの102行目、

@torch.no_grad()

def worker(input_image, prompt, n_prompt, seed, total_second_length, latent_window_size, steps, cfg, gs, rs, gpu_memory_preservation, use_teacache, mp4_crf):

をみると、確かに、ここがコア処理をしてるように見えますね。

worker関数の引数名も、インプットイメージ、プロンプト、ネガティブプロンプト?seed、トータル時間など、WebUIで利用する際によく見る項目がすべて並んでいますので、この関数に必要な引数を渡すと動くようには見えます。

記載していただいた、run_framepack.pyを見ると、demo_gradio.pyをインポートしないとダメな気はしますね。

import demo_gradio

はい、その通りです!お見事な読み取りです。

✅ demo_gradio.py の worker() 関数は、Gradio UIを介さずに直接呼び出して動画生成できる中核関数なので、それを別スクリプトで使う場合には:

import demo_gradio

でインポートし、以下のように demo_gradio.worker(…) で実行できます。

🔧 たとえば、以下のような run_framepack.py が組めます:

# run_framepack.py

import demo_gradio

from PIL import Image

import numpy as np

# 入力画像読み込み

input_image = np.array(Image.open("framepack_cli_test/input.jpg").convert("RGB"))

# パラメータ(WebUIと同等の値を設定)

prompt = "少女が手を振る"

n_prompt = "" # ネガティブプロンプト(空欄でもOK)

seed = 1234

total_second_length = 5

latent_window_size = 9

steps = 25

cfg = 1.0

gs = 10.0

rs = 0.0

gpu_memory_preservation = 6

use_teacache = True

mp4_crf = 16

# 実行(worker関数呼び出し)

demo_gradio.worker(

input_image, prompt, n_prompt, seed, total_second_length,

latent_window_size, steps, cfg, gs, rs,

gpu_memory_preservation, use_teacache, mp4_crf

)

✅ 補足 demo_gradio.py と同じフォルダに run_framepack.py を置いて実行すればOKです(webui/ ディレクトリ内に配置)

input.jpg は画像1枚テスト用として framepack_cli_test/ フォルダに入れておけば読み込まれます

生成されたMP4は outputs/ に保存されるはずです(内部で generate_timestamp() を使って命名)

補足:依存関係の確認 実行前に以下ライブラリが必要です:

pip install numpy pillow

🎯 次のステップ(ご希望なら)

- 複数ファイルを一括処理できるよう glob.glob() を使ってループ化

- コマンドライン引数で –prompt や –input_dir を指定できるように

- 処理ログやエラー出力の追加

python run_framepack.py Traceback (most recent call last): File “C:\AI\framepack_cu126_torch26\webui\run_framepack.py”, line 2, in

import demo_gradio File “C:\AI\framepack_cu126_torch26\webui\demo_gradio.py”, line 7, in import gradio as gr ModuleNotFoundError: No module named ‘gradio’

関節的に一部のPythonファイルを読込み動作せるのは無理がありそうですね…。 endframe_ichi.pyをインポートすると解決できる?

❌ demo_gradio.py を直接インポートすると、gradio モジュールが必要 (→つまり WebUI 前提の余計な読み込みが入ってしまう)

✅ 解決策:worker() 関数だけを Gradio に依存しない形で分離する つまり:

🛠 1. core_worker.py などとしてコア処理を切り出す(Gradio不要)

# core_worker.py

import torch

from PIL import Image

import numpy as np

import ffmpeg

import os

import datetime

@torch.no_grad()

def worker(input_image, prompt, n_prompt, seed, total_second_length,

latent_window_size, steps, cfg, gs, rs, gpu_memory_preservation,

use_teacache, mp4_crf):

# 実際の生成処理をここにコピペ(demo_gradio.py 102行目〜)

# ※ 必要なら demo_gradio.py の該当コードをこのファイルに移植

pass

🧪 2. run_framepack.py はこれを使って実行

# run_framepack.py

from PIL import Image

import numpy as np

import core_worker # Gradioに依存しない版

img = np.array(Image.open("framepack_cli_test/input.jpg").convert("RGB"))

core_worker.worker(

img,

prompt="少女が手を振る",

n_prompt="",

seed=1234,

total_second_length=5,

latent_window_size=9,

steps=25,

cfg=1.0,

gs=10.0,

rs=0.0,

gpu_memory_preservation=6,

use_teacache=True,

mp4_crf=16

)

✅ こうすれば: WebUI(Gradio)が無くても使える

CLIやバッチ処理にも対応しやすい

endframe_ichi.py をわざわざ使わず、自前で制御できる

✍️ ちなみに endframe_ichi.py は GradioをWebUIで起動するだけのスクリプトなので、 直接的な制御ロジックは含まれていません。なので…

❌ endframe_ichi.pyのインポートは「見かけ倒し」で意味がないです

✅ おすすめ手順(まとめ)

| 手順 | 内容 |

|---|---|

| 1 | demo_gradio.py の worker() 関数の中身を core_worker.py にコピー(gradio不要に) |

| 2 | 依存ライブラリ(gr, demo_ui など)を削除 |

| 3 | run_framepack.py で core_worker を呼び出し、テスト実行 |

モジュール類のインストール

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 3, in <module>

import numpy as np

ModuleNotFoundError: No module named 'numpy'

無かったのでインストール。

>pip install numpy pillow

Collecting numpy

Using cached numpy-2.2.6-cp310-cp310-win_amd64.whl.metadata (60 kB)

Requirement already satisfied: pillow in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (10.1.0)

Using cached numpy-2.2.6-cp310-cp310-win_amd64.whl (12.9 MB)

Installing collected packages: numpy

Successfully installed numpy-2.2.6

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 4, in <module>

import core_worker # Gradioに依存しない版

File "C:\AI\framepack_cu126_torch26\webui\core_worker.py", line 2, in <module>

import torch

ModuleNotFoundError: No module named 'torch'

>pip install torch

Collecting torch

Downloading torch-2.7.1-cp310-cp310-win_amd64.whl.metadata (28 kB)

Collecting filelock (from torch)

Using cached filelock-3.18.0-py3-none-any.whl.metadata (2.9 kB)

Requirement already satisfied: typing-extensions>=4.10.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch) (4.13.2)

Collecting sympy>=1.13.3 (from torch)

Using cached sympy-1.14.0-py3-none-any.whl.metadata (12 kB)

Collecting networkx (from torch)

Using cached networkx-3.4.2-py3-none-any.whl.metadata (6.3 kB)

Collecting jinja2 (from torch)

Using cached jinja2-3.1.6-py3-none-any.whl.metadata (2.9 kB)

Collecting fsspec (from torch)

Using cached fsspec-2025.5.1-py3-none-any.whl.metadata (11 kB)

Collecting mpmath<1.4,>=1.1.0 (from sympy>=1.13.3->torch)

Downloading mpmath-1.3.0-py3-none-any.whl.metadata (8.6 kB)

Collecting MarkupSafe>=2.0 (from jinja2->torch)

Using cached MarkupSafe-3.0.2-cp310-cp310-win_amd64.whl.metadata (4.1 kB)

Downloading torch-2.7.1-cp310-cp310-win_amd64.whl (216.1 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 216.1/216.1 MB 55.9 MB/s eta 0:00:00

Using cached sympy-1.14.0-py3-none-any.whl (6.3 MB)

Downloading mpmath-1.3.0-py3-none-any.whl (536 kB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 536.2/536.2 kB 17.1 MB/s eta 0:00:00

Using cached filelock-3.18.0-py3-none-any.whl (16 kB)

Using cached fsspec-2025.5.1-py3-none-any.whl (199 kB)

Using cached jinja2-3.1.6-py3-none-any.whl (134 kB)

Using cached MarkupSafe-3.0.2-cp310-cp310-win_amd64.whl (15 kB)

Using cached networkx-3.4.2-py3-none-any.whl (1.7 MB)

Installing collected packages: mpmath, sympy, networkx, MarkupSafe, fsspec, filelock, jinja2, torch

Successfully installed MarkupSafe-3.0.2 filelock-3.18.0 fsspec-2025.5.1 jinja2-3.1.6 mpmath-1.3.0 networkx-3.4.2 sympy-1.14.0 torch-2.7.1

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 4, in <module>

import core_worker # Gradioに依存しない版

File "C:\AI\framepack_cu126_torch26\webui\core_worker.py", line 5, in <module>

import ffmpeg

ModuleNotFoundError: No module named 'ffmpeg'

>pip install ffmpeg

Collecting ffmpeg

Downloading ffmpeg-1.4.tar.gz (5.1 kB)

Installing build dependencies ... done

Getting requirements to build wheel ... done

Preparing metadata (pyproject.toml) ... done

Building wheels for collected packages: ffmpeg

Building wheel for ffmpeg (pyproject.toml) ... done

Created wheel for ffmpeg: filename=ffmpeg-1.4-py3-none-any.whl size=6138 sha256=19a6f4af10d673c4e8ba4d5ffb4338a04fd5d093a7f41f8245f733442ae9e74d

Stored in directory: c:\users\user-name\appdata\local\pip\cache\wheels\8e\7a\69\cd6aeb83b126a7f04cbe7c9d929028dc52a6e7d525ff56003a

Successfully built ffmpeg

Installing collected packages: ffmpeg

Successfully installed ffmpeg-1.4

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 8, in <module>

core_worker.worker(

File "C:\Users\user-name\AppData\Local\Programs\Python\Python310\lib\site-packages\torch\utils\_contextlib.py", line 116, in decorate_context

return func(*args, **kwargs)

File "C:\AI\framepack_cu126_torch26\webui\core_worker.py", line 15, in worker

job_id = generate_timestamp()

NameError: name 'generate_timestamp' is not defined

試しに以下を追加。

from demo_gradio import generate_timestamp

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 5, in <module>

from demo_gradio import generate_timestamp

File "C:\AI\framepack_cu126_torch26\webui\demo_gradio.py", line 7, in <module>

import gradio as gr

ModuleNotFoundError: No module named 'gradio'

>pip install gradio

Collecting gradio

Downloading gradio-5.34.0-py3-none-any.whl.metadata (16 kB)

Collecting aiofiles<25.0,>=22.0 (from gradio)

Downloading aiofiles-24.1.0-py3-none-any.whl.metadata (10 kB)

Collecting anyio<5.0,>=3.0 (from gradio)

Downloading anyio-4.9.0-py3-none-any.whl.metadata (4.7 kB)

Collecting fastapi<1.0,>=0.115.2 (from gradio)

Downloading fastapi-0.115.12-py3-none-any.whl.metadata (27 kB)

Collecting ffmpy (from gradio)

Using cached ffmpy-0.6.0-py3-none-any.whl.metadata (2.9 kB)

Collecting gradio-client==1.10.3 (from gradio)

Downloading gradio_client-1.10.3-py3-none-any.whl.metadata (7.1 kB)

Collecting groovy~=0.1 (from gradio)

Downloading groovy-0.1.2-py3-none-any.whl.metadata (6.1 kB)

Collecting httpx>=0.24.1 (from gradio)

Downloading httpx-0.28.1-py3-none-any.whl.metadata (7.1 kB)

Collecting huggingface-hub>=0.28.1 (from gradio)

Downloading huggingface_hub-0.33.0-py3-none-any.whl.metadata (14 kB)

Requirement already satisfied: jinja2<4.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from gradio) (3.1.6)

Requirement already satisfied: markupsafe<4.0,>=2.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from gradio) (3.0.2)

Requirement already satisfied: numpy<3.0,>=1.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from gradio) (2.2.6)

Collecting orjson~=3.0 (from gradio)

Using cached orjson-3.10.18-cp310-cp310-win_amd64.whl.metadata (43 kB)

Requirement already satisfied: packaging in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from gradio) (25.0)

Collecting pandas<3.0,>=1.0 (from gradio)

Using cached pandas-2.3.0-cp310-cp310-win_amd64.whl.metadata (19 kB)

Requirement already satisfied: pillow<12.0,>=8.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from gradio) (10.1.0)

Collecting pydantic<2.12,>=2.0 (from gradio)

Downloading pydantic-2.11.6-py3-none-any.whl.metadata (67 kB)

Collecting pydub (from gradio)

Using cached pydub-0.25.1-py2.py3-none-any.whl.metadata (1.4 kB)

Collecting python-multipart>=0.0.18 (from gradio)

Using cached python_multipart-0.0.20-py3-none-any.whl.metadata (1.8 kB)

Requirement already satisfied: pyyaml<7.0,>=5.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from gradio) (6.0.2)

Collecting ruff>=0.9.3 (from gradio)

Downloading ruff-0.11.13-py3-none-win_amd64.whl.metadata (26 kB)

Collecting safehttpx<0.2.0,>=0.1.6 (from gradio)

Downloading safehttpx-0.1.6-py3-none-any.whl.metadata (4.2 kB)

Collecting semantic-version~=2.0 (from gradio)

Using cached semantic_version-2.10.0-py2.py3-none-any.whl.metadata (9.7 kB)

Collecting starlette<1.0,>=0.40.0 (from gradio)

Downloading starlette-0.47.0-py3-none-any.whl.metadata (6.2 kB)

Collecting tomlkit<0.14.0,>=0.12.0 (from gradio)

Downloading tomlkit-0.13.3-py3-none-any.whl.metadata (2.8 kB)

Collecting typer<1.0,>=0.12 (from gradio)

Downloading typer-0.16.0-py3-none-any.whl.metadata (15 kB)

Requirement already satisfied: typing-extensions~=4.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from gradio) (4.13.2)

Collecting uvicorn>=0.14.0 (from gradio)

Using cached uvicorn-0.34.3-py3-none-any.whl.metadata (6.5 kB)

Requirement already satisfied: fsspec in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from gradio-client==1.10.3->gradio) (2025.5.1)

Collecting websockets<16.0,>=10.0 (from gradio-client==1.10.3->gradio)

Downloading websockets-15.0.1-cp310-cp310-win_amd64.whl.metadata (7.0 kB)

Collecting exceptiongroup>=1.0.2 (from anyio<5.0,>=3.0->gradio)

Using cached exceptiongroup-1.3.0-py3-none-any.whl.metadata (6.7 kB)

Requirement already satisfied: idna>=2.8 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from anyio<5.0,>=3.0->gradio) (3.10)

Collecting sniffio>=1.1 (from anyio<5.0,>=3.0->gradio)

Using cached sniffio-1.3.1-py3-none-any.whl.metadata (3.9 kB)

Collecting starlette<1.0,>=0.40.0 (from gradio)

Downloading starlette-0.46.2-py3-none-any.whl.metadata (6.2 kB)

Collecting python-dateutil>=2.8.2 (from pandas<3.0,>=1.0->gradio)

Using cached python_dateutil-2.9.0.post0-py2.py3-none-any.whl.metadata (8.4 kB)

Collecting pytz>=2020.1 (from pandas<3.0,>=1.0->gradio)

Using cached pytz-2025.2-py2.py3-none-any.whl.metadata (22 kB)

Collecting tzdata>=2022.7 (from pandas<3.0,>=1.0->gradio)

Using cached tzdata-2025.2-py2.py3-none-any.whl.metadata (1.4 kB)

Collecting annotated-types>=0.6.0 (from pydantic<2.12,>=2.0->gradio)

Downloading annotated_types-0.7.0-py3-none-any.whl.metadata (15 kB)

Collecting pydantic-core==2.33.2 (from pydantic<2.12,>=2.0->gradio)

Downloading pydantic_core-2.33.2-cp310-cp310-win_amd64.whl.metadata (6.9 kB)

Collecting typing-inspection>=0.4.0 (from pydantic<2.12,>=2.0->gradio)

Downloading typing_inspection-0.4.1-py3-none-any.whl.metadata (2.6 kB)

Collecting click>=8.0.0 (from typer<1.0,>=0.12->gradio)

Using cached click-8.2.1-py3-none-any.whl.metadata (2.5 kB)

Collecting shellingham>=1.3.0 (from typer<1.0,>=0.12->gradio)

Downloading shellingham-1.5.4-py2.py3-none-any.whl.metadata (3.5 kB)

Collecting rich>=10.11.0 (from typer<1.0,>=0.12->gradio)

Downloading rich-14.0.0-py3-none-any.whl.metadata (18 kB)

Collecting colorama (from click>=8.0.0->typer<1.0,>=0.12->gradio)

Using cached colorama-0.4.6-py2.py3-none-any.whl.metadata (17 kB)

Requirement already satisfied: certifi in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from httpx>=0.24.1->gradio) (2025.4.26)

Collecting httpcore==1.* (from httpx>=0.24.1->gradio)

Downloading httpcore-1.0.9-py3-none-any.whl.metadata (21 kB)

Collecting h11>=0.16 (from httpcore==1.*->httpx>=0.24.1->gradio)

Downloading h11-0.16.0-py3-none-any.whl.metadata (8.3 kB)

Requirement already satisfied: filelock in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from huggingface-hub>=0.28.1->gradio) (3.18.0)

Requirement already satisfied: requests in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from huggingface-hub>=0.28.1->gradio) (2.32.3)

Collecting tqdm>=4.42.1 (from huggingface-hub>=0.28.1->gradio)

Using cached tqdm-4.67.1-py3-none-any.whl.metadata (57 kB)

Requirement already satisfied: six>=1.5 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from python-dateutil>=2.8.2->pandas<3.0,>=1.0->gradio) (1.17.0)

Collecting markdown-it-py>=2.2.0 (from rich>=10.11.0->typer<1.0,>=0.12->gradio)

Downloading markdown_it_py-3.0.0-py3-none-any.whl.metadata (6.9 kB)

Collecting pygments<3.0.0,>=2.13.0 (from rich>=10.11.0->typer<1.0,>=0.12->gradio)

Downloading pygments-2.19.1-py3-none-any.whl.metadata (2.5 kB)

Collecting mdurl~=0.1 (from markdown-it-py>=2.2.0->rich>=10.11.0->typer<1.0,>=0.12->gradio)

Downloading mdurl-0.1.2-py3-none-any.whl.metadata (1.6 kB)

Requirement already satisfied: charset-normalizer<4,>=2 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from requests->huggingface-hub>=0.28.1->gradio) (3.4.2)

Requirement already satisfied: urllib3<3,>=1.21.1 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from requests->huggingface-hub>=0.28.1->gradio) (2.4.0)

Downloading gradio-5.34.0-py3-none-any.whl (54.3 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 54.3/54.3 MB 44.3 MB/s eta 0:00:00

Downloading gradio_client-1.10.3-py3-none-any.whl (323 kB)

Downloading aiofiles-24.1.0-py3-none-any.whl (15 kB)

Downloading anyio-4.9.0-py3-none-any.whl (100 kB)

Downloading fastapi-0.115.12-py3-none-any.whl (95 kB)

Downloading groovy-0.1.2-py3-none-any.whl (14 kB)

Using cached orjson-3.10.18-cp310-cp310-win_amd64.whl (134 kB)

Using cached pandas-2.3.0-cp310-cp310-win_amd64.whl (11.1 MB)

Downloading pydantic-2.11.6-py3-none-any.whl (444 kB)

Downloading pydantic_core-2.33.2-cp310-cp310-win_amd64.whl (2.0 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 2.0/2.0 MB 52.9 MB/s eta 0:00:00

Downloading safehttpx-0.1.6-py3-none-any.whl (8.7 kB)

Using cached semantic_version-2.10.0-py2.py3-none-any.whl (15 kB)

Downloading starlette-0.46.2-py3-none-any.whl (72 kB)

Downloading tomlkit-0.13.3-py3-none-any.whl (38 kB)

Downloading typer-0.16.0-py3-none-any.whl (46 kB)

Downloading websockets-15.0.1-cp310-cp310-win_amd64.whl (176 kB)

Downloading annotated_types-0.7.0-py3-none-any.whl (13 kB)

Using cached click-8.2.1-py3-none-any.whl (102 kB)

Using cached exceptiongroup-1.3.0-py3-none-any.whl (16 kB)

Downloading httpx-0.28.1-py3-none-any.whl (73 kB)

Downloading httpcore-1.0.9-py3-none-any.whl (78 kB)

Downloading h11-0.16.0-py3-none-any.whl (37 kB)

Downloading huggingface_hub-0.33.0-py3-none-any.whl (514 kB)

Using cached python_dateutil-2.9.0.post0-py2.py3-none-any.whl (229 kB)

Using cached python_multipart-0.0.20-py3-none-any.whl (24 kB)

Using cached pytz-2025.2-py2.py3-none-any.whl (509 kB)

Downloading rich-14.0.0-py3-none-any.whl (243 kB)

Downloading pygments-2.19.1-py3-none-any.whl (1.2 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 1.2/1.2 MB 64.2 MB/s eta 0:00:00

Downloading markdown_it_py-3.0.0-py3-none-any.whl (87 kB)

Downloading mdurl-0.1.2-py3-none-any.whl (10.0 kB)

Downloading ruff-0.11.13-py3-none-win_amd64.whl (11.5 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 11.5/11.5 MB 60.0 MB/s eta 0:00:00

Downloading shellingham-1.5.4-py2.py3-none-any.whl (9.8 kB)

Using cached sniffio-1.3.1-py3-none-any.whl (10 kB)

Using cached tqdm-4.67.1-py3-none-any.whl (78 kB)

Downloading typing_inspection-0.4.1-py3-none-any.whl (14 kB)

Using cached tzdata-2025.2-py2.py3-none-any.whl (347 kB)

Using cached uvicorn-0.34.3-py3-none-any.whl (62 kB)

Using cached colorama-0.4.6-py2.py3-none-any.whl (25 kB)

Using cached ffmpy-0.6.0-py3-none-any.whl (5.5 kB)

Using cached pydub-0.25.1-py2.py3-none-any.whl (32 kB)

Installing collected packages: pytz, pydub, websockets, tzdata, typing-inspection, tomlkit, sniffio, shellingham, semantic-version, ruff, python-multipart, python-dateutil, pygments, pydantic-core, orjson, mdurl, h11, groovy, ffmpy, exceptiongroup, colorama, annotated-types, aiofiles, tqdm, pydantic, pandas, markdown-it-py, httpcore, click, anyio, uvicorn, starlette, rich, huggingface-hub, httpx, typer, safehttpx, gradio-client, fastapi, gradio

Successfully installed aiofiles-24.1.0 annotated-types-0.7.0 anyio-4.9.0 click-8.2.1 colorama-0.4.6 exceptiongroup-1.3.0 fastapi-0.115.12 ffmpy-0.6.0 gradio-5.34.0 gradio-client-1.10.3 groovy-0.1.2 h11-0.16.0 httpcore-1.0.9 httpx-0.28.1 huggingface-hub-0.33.0 markdown-it-py-3.0.0 mdurl-0.1.2 orjson-3.10.18 pandas-2.3.0 pydantic-2.11.6 pydantic-core-2.33.2 pydub-0.25.1 pygments-2.19.1 python-dateutil-2.9.0.post0 python-multipart-0.0.20 pytz-2025.2 rich-14.0.0 ruff-0.11.13 safehttpx-0.1.6 semantic-version-2.10.0 shellingham-1.5.4 sniffio-1.3.1 starlette-0.46.2 tomlkit-0.13.3 tqdm-4.67.1 typer-0.16.0 typing-inspection-0.4.1 tzdata-2025.2 uvicorn-0.34.3 websockets-15.0.1

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 5, in <module>

from demo_gradio import generate_timestamp

File "C:\AI\framepack_cu126_torch26\webui\demo_gradio.py", line 10, in <module>

import einops

ModuleNotFoundError: No module named 'einops'

>pip install einops

Collecting einops

Downloading einops-0.8.1-py3-none-any.whl.metadata (13 kB)

Downloading einops-0.8.1-py3-none-any.whl (64 kB)

Installing collected packages: einops

Successfully installed einops-0.8.1

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 5, in <module>

from demo_gradio import generate_timestamp

File "C:\AI\framepack_cu126_torch26\webui\demo_gradio.py", line 11, in <module>

import safetensors.torch as sf

ModuleNotFoundError: No module named 'safetensors'

>pip install safetensors

Collecting safetensors

Downloading safetensors-0.5.3-cp38-abi3-win_amd64.whl.metadata (3.9 kB)

Downloading safetensors-0.5.3-cp38-abi3-win_amd64.whl (308 kB)

Installing collected packages: safetensors

Successfully installed safetensors-0.5.3

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 5, in <module>

from demo_gradio import generate_timestamp

File "C:\AI\framepack_cu126_torch26\webui\demo_gradio.py", line 17, in <module>

from diffusers import AutoencoderKLHunyuanVideo

ModuleNotFoundError: No module named 'diffusers'

>pip install diffusers

Collecting diffusers

Downloading diffusers-0.33.1-py3-none-any.whl.metadata (19 kB)

Collecting importlib-metadata (from diffusers)

Downloading importlib_metadata-8.7.0-py3-none-any.whl.metadata (4.8 kB)

Requirement already satisfied: filelock in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from diffusers) (3.18.0)

Requirement already satisfied: huggingface-hub>=0.27.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from diffusers) (0.33.0)

Requirement already satisfied: numpy in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from diffusers) (2.2.6)

Collecting regex!=2019.12.17 (from diffusers)

Using cached regex-2024.11.6-cp310-cp310-win_amd64.whl.metadata (41 kB)

Requirement already satisfied: requests in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from diffusers) (2.32.3)

Requirement already satisfied: safetensors>=0.3.1 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from diffusers) (0.5.3)

Requirement already satisfied: Pillow in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from diffusers) (10.1.0)

Requirement already satisfied: fsspec>=2023.5.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from huggingface-hub>=0.27.0->diffusers) (2025.5.1)

Requirement already satisfied: packaging>=20.9 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from huggingface-hub>=0.27.0->diffusers) (25.0)

Requirement already satisfied: pyyaml>=5.1 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from huggingface-hub>=0.27.0->diffusers) (6.0.2)

Requirement already satisfied: tqdm>=4.42.1 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from huggingface-hub>=0.27.0->diffusers) (4.67.1)

Requirement already satisfied: typing-extensions>=3.7.4.3 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from huggingface-hub>=0.27.0->diffusers) (4.13.2)

Requirement already satisfied: colorama in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from tqdm>=4.42.1->huggingface-hub>=0.27.0->diffusers) (0.4.6)

Collecting zipp>=3.20 (from importlib-metadata->diffusers)

Downloading zipp-3.23.0-py3-none-any.whl.metadata (3.6 kB)

Requirement already satisfied: charset-normalizer<4,>=2 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from requests->diffusers) (3.4.2)

Requirement already satisfied: idna<4,>=2.5 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from requests->diffusers) (3.10)

Requirement already satisfied: urllib3<3,>=1.21.1 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from requests->diffusers) (2.4.0)

Requirement already satisfied: certifi>=2017.4.17 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from requests->diffusers) (2025.4.26)

Downloading diffusers-0.33.1-py3-none-any.whl (3.6 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 3.6/3.6 MB 52.3 MB/s eta 0:00:00

Using cached regex-2024.11.6-cp310-cp310-win_amd64.whl (274 kB)

Downloading importlib_metadata-8.7.0-py3-none-any.whl (27 kB)

Downloading zipp-3.23.0-py3-none-any.whl (10 kB)

Installing collected packages: zipp, regex, importlib-metadata, diffusers

Successfully installed diffusers-0.33.1 importlib-metadata-8.7.0 regex-2024.11.6 zipp-3.23.0

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 5, in <module>

from demo_gradio import generate_timestamp

File "C:\AI\framepack_cu126_torch26\webui\demo_gradio.py", line 18, in <module>

from transformers import LlamaModel, CLIPTextModel, LlamaTokenizerFast, CLIPTokenizer

ModuleNotFoundError: No module named 'transformers'

>pip install transformers

Collecting transformers

Downloading transformers-4.52.4-py3-none-any.whl.metadata (38 kB)

Requirement already satisfied: filelock in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from transformers) (3.18.0)

Requirement already satisfied: huggingface-hub<1.0,>=0.30.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from transformers) (0.33.0)

Requirement already satisfied: numpy>=1.17 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from transformers) (2.2.6)

Requirement already satisfied: packaging>=20.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from transformers) (25.0)

Requirement already satisfied: pyyaml>=5.1 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from transformers) (6.0.2)

Requirement already satisfied: regex!=2019.12.17 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from transformers) (2024.11.6)

Requirement already satisfied: requests in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from transformers) (2.32.3)

Collecting tokenizers<0.22,>=0.21 (from transformers)

Downloading tokenizers-0.21.1-cp39-abi3-win_amd64.whl.metadata (6.9 kB)

Requirement already satisfied: safetensors>=0.4.3 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from transformers) (0.5.3)

Requirement already satisfied: tqdm>=4.27 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from transformers) (4.67.1)

Requirement already satisfied: fsspec>=2023.5.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from huggingface-hub<1.0,>=0.30.0->transformers) (2025.5.1)

Requirement already satisfied: typing-extensions>=3.7.4.3 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from huggingface-hub<1.0,>=0.30.0->transformers) (4.13.2)

Requirement already satisfied: colorama in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from tqdm>=4.27->transformers) (0.4.6)

Requirement already satisfied: charset-normalizer<4,>=2 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from requests->transformers) (3.4.2)

Requirement already satisfied: idna<4,>=2.5 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from requests->transformers) (3.10)

Requirement already satisfied: urllib3<3,>=1.21.1 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from requests->transformers) (2.4.0)

Requirement already satisfied: certifi>=2017.4.17 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from requests->transformers) (2025.4.26)

Downloading transformers-4.52.4-py3-none-any.whl (10.5 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 10.5/10.5 MB 59.3 MB/s eta 0:00:00

Downloading tokenizers-0.21.1-cp39-abi3-win_amd64.whl (2.4 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 2.4/2.4 MB 70.1 MB/s eta 0:00:00

Installing collected packages: tokenizers, transformers

Successfully installed tokenizers-0.21.1 transformers-4.52.4

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 5, in <module>

from demo_gradio import generate_timestamp

File "C:\AI\framepack_cu126_torch26\webui\demo_gradio.py", line 19, in <module>

from diffusers_helper.hunyuan import encode_prompt_conds, vae_decode, vae_encode, vae_decode_fake

File "C:\AI\framepack_cu126_torch26\webui\diffusers_helper\hunyuan.py", line 4, in <module>

from diffusers_helper.utils import crop_or_pad_yield_mask

File "C:\AI\framepack_cu126_torch26\webui\diffusers_helper\utils.py", line 2, in <module>

import cv2

ModuleNotFoundError: No module named 'cv2'

OpenCVをインストール

かなり沢山のモジュールが必要で、エラーが出るたびにインストールを繰り返してます。 経過については、常時ブログで追加更新してますので、URLで確認できます。

https://humanxai.info/posts/framepack-practice-08/

現在、No module named ‘cv2’ で止まってます。

そのエラーはよくある落とし穴です。 cv2 は OpenCV パッケージのモジュール名ですが、pip install cv2 ではインストールできません。

正しくは:

pip install opencv-python

また、もしGUI機能(cv2.imshow()など)を一切使わないならこれでOKですが、必要であれば以下も追加でどうぞ:

pip install opencv-python-headless

- opencv-python:GUI機能付き(WindowsユーザーはこちらでOK)

- opencv-python-headless:GUIなし。サーバー用途やDocker環境向け

💡補足 今後も demo_gradio.py 系を参照する以上、以下のような追加モジュールのインストールが続く可能性があります:

| モジュール | 推定用途 |

|---|---|

opencv-python |

画像処理(cv2) |

transformers |

テキスト処理/モデル読み込み |

diffusers |

スケジューラ、モデル推論 |

omegaconf |

YAML設定の読み込み |

einops |

テンソル変形 |

gradio |

Web UIに必要(CLIなら不要) |

何か新しいエラーが出たら、遠慮なく貼ってください。ブログも順調に進んでいて読み応えがありますね。引き続き一緒に解決していきましょう。

モジュールの詳細ありがとうございます。 参考になります。

>pip install opencv-python

Collecting opencv-python

Using cached opencv_python-4.11.0.86-cp37-abi3-win_amd64.whl.metadata (20 kB)

Requirement already satisfied: numpy>=1.21.2 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from opencv-python) (2.2.6)

Using cached opencv_python-4.11.0.86-cp37-abi3-win_amd64.whl (39.5 MB)

Installing collected packages: opencv-python

Successfully installed opencv-python-4.11.0.86

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 5, in <module>

from demo_gradio import generate_timestamp

File "C:\AI\framepack_cu126_torch26\webui\demo_gradio.py", line 19, in <module>

from diffusers_helper.hunyuan import encode_prompt_conds, vae_decode, vae_encode, vae_decode_fake

File "C:\AI\framepack_cu126_torch26\webui\diffusers_helper\hunyuan.py", line 4, in <module>

from diffusers_helper.utils import crop_or_pad_yield_mask

File "C:\AI\framepack_cu126_torch26\webui\diffusers_helper\utils.py", line 10, in <module>

import torchvision

ModuleNotFoundError: No module named 'torchvision'

>pip install torchvision

Collecting torchvision

Downloading torchvision-0.22.1-cp310-cp310-win_amd64.whl.metadata (6.1 kB)

Requirement already satisfied: numpy in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torchvision) (2.2.6)

Requirement already satisfied: torch==2.7.1 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torchvision) (2.7.1)

Requirement already satisfied: pillow!=8.3.*,>=5.3.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torchvision) (10.1.0)

Requirement already satisfied: filelock in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch==2.7.1->torchvision) (3.18.0)

Requirement already satisfied: typing-extensions>=4.10.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch==2.7.1->torchvision) (4.13.2)

Requirement already satisfied: sympy>=1.13.3 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch==2.7.1->torchvision) (1.14.0)

Requirement already satisfied: networkx in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch==2.7.1->torchvision) (3.4.2)

Requirement already satisfied: jinja2 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch==2.7.1->torchvision) (3.1.6)

Requirement already satisfied: fsspec in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch==2.7.1->torchvision) (2025.5.1)

Requirement already satisfied: mpmath<1.4,>=1.1.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from sympy>=1.13.3->torch==2.7.1->torchvision) (1.3.0)

Requirement already satisfied: MarkupSafe>=2.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from jinja2->torch==2.7.1->torchvision) (3.0.2)

Downloading torchvision-0.22.1-cp310-cp310-win_amd64.whl (1.7 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 1.7/1.7 MB 46.6 MB/s eta 0:00:00

Installing collected packages: torchvision

Successfully installed torchvision-0.22.1

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 5, in <module>

from demo_gradio import generate_timestamp

File "C:\AI\framepack_cu126_torch26\webui\demo_gradio.py", line 21, in <module>

from diffusers_helper.models.hunyuan_video_packed import HunyuanVideoTransformer3DModelPacked

File "C:\AI\framepack_cu126_torch26\webui\diffusers_helper\models\hunyuan_video_packed.py", line 17, in <module>

from diffusers_helper.dit_common import LayerNorm

File "C:\AI\framepack_cu126_torch26\webui\diffusers_helper\dit_common.py", line 2, in <module>

import accelerate.accelerator

ModuleNotFoundError: No module named 'accelerate'

>pip install accelerate

Collecting accelerate

Downloading accelerate-1.7.0-py3-none-any.whl.metadata (19 kB)

Requirement already satisfied: numpy<3.0.0,>=1.17 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from accelerate) (2.2.6)

Requirement already satisfied: packaging>=20.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from accelerate) (25.0)

Collecting psutil (from accelerate)

Downloading psutil-7.0.0-cp37-abi3-win_amd64.whl.metadata (23 kB)

Requirement already satisfied: pyyaml in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from accelerate) (6.0.2)

Requirement already satisfied: torch>=2.0.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from accelerate) (2.7.1)

Requirement already satisfied: huggingface-hub>=0.21.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from accelerate) (0.33.0)

Requirement already satisfied: safetensors>=0.4.3 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from accelerate) (0.5.3)

Requirement already satisfied: filelock in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from huggingface-hub>=0.21.0->accelerate) (3.18.0)

Requirement already satisfied: fsspec>=2023.5.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from huggingface-hub>=0.21.0->accelerate) (2025.5.1)

Requirement already satisfied: requests in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from huggingface-hub>=0.21.0->accelerate) (2.32.3)

Requirement already satisfied: tqdm>=4.42.1 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from huggingface-hub>=0.21.0->accelerate) (4.67.1)

Requirement already satisfied: typing-extensions>=3.7.4.3 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from huggingface-hub>=0.21.0->accelerate) (4.13.2)

Requirement already satisfied: sympy>=1.13.3 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch>=2.0.0->accelerate) (1.14.0)

Requirement already satisfied: networkx in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch>=2.0.0->accelerate) (3.4.2)

Requirement already satisfied: jinja2 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch>=2.0.0->accelerate) (3.1.6)

Requirement already satisfied: mpmath<1.4,>=1.1.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from sympy>=1.13.3->torch>=2.0.0->accelerate) (1.3.0)

Requirement already satisfied: colorama in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from tqdm>=4.42.1->huggingface-hub>=0.21.0->accelerate) (0.4.6)

Requirement already satisfied: MarkupSafe>=2.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from jinja2->torch>=2.0.0->accelerate) (3.0.2)

Requirement already satisfied: charset-normalizer<4,>=2 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from requests->huggingface-hub>=0.21.0->accelerate) (3.4.2)

Requirement already satisfied: idna<4,>=2.5 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from requests->huggingface-hub>=0.21.0->accelerate) (3.10)

Requirement already satisfied: urllib3<3,>=1.21.1 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from requests->huggingface-hub>=0.21.0->accelerate) (2.4.0)

Requirement already satisfied: certifi>=2017.4.17 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from requests->huggingface-hub>=0.21.0->accelerate) (2025.4.26)

Downloading accelerate-1.7.0-py3-none-any.whl (362 kB)

Downloading psutil-7.0.0-cp37-abi3-win_amd64.whl (244 kB)

Installing collected packages: psutil, accelerate

Successfully installed accelerate-1.7.0 psutil-7.0.0

CUDA対応版の PyTorch をインストール

うごく寸前まで来たかも…。

>python run_framepack.py

Currently enabled native sdp backends: ['flash', 'math', 'mem_efficient', 'cudnn']

Xformers is not installed!

Flash Attn is not installed!

Sage Attn is not installed!

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 5, in <module>

from demo_gradio import generate_timestamp

File "C:\AI\framepack_cu126_torch26\webui\demo_gradio.py", line 23, in <module>

from diffusers_helper.memory import cpu, gpu, get_cuda_free_memory_gb, move_model_to_device_with_memory_preservation, offload_model_from_device_for_memory_preservation, fake_diffusers_current_device, DynamicSwapInstaller, unload_complete_models, load_model_as_complete

File "C:\AI\framepack_cu126_torch26\webui\diffusers_helper\memory.py", line 8, in <module>

gpu = torch.device(f'cuda:{torch.cuda.current_device()}')

File "C:\Users\user-name\AppData\Local\Programs\Python\Python310\lib\site-packages\torch\cuda\__init__.py", line 1026, in current_device

_lazy_init()

File "C:\Users\user-name\AppData\Local\Programs\Python\Python310\lib\site-packages\torch\cuda\__init__.py", line 363, in _lazy_init

raise AssertionError("Torch not compiled with CUDA enabled")

AssertionError: Torch not compiled with CUDA enabled

ほぼ起動直前まで到達していますね! このエラーは、PyTorch が CUDA 対応版じゃない ために、GPUを使おうとして失敗しているものです。

🔍 エラーの要点

AssertionError: Torch not compiled with CUDA enabled

これは「PyTorch が CUDA を使えないビルドでインストールされている」という意味です。つまり:

- torch のバージョンが CPU専用版

- torch.cuda.current_device() を呼んだ時点でクラッシュ

✅ 解決策:CUDA対応版の PyTorch を再インストール

- 既存のPyTorchをアンインストール

pip uninstall torch

- CUDA 12.1対応の PyTorch をインストール(FramePack の cu126 に対応)

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

※ CUDA 12.6対応が必要な場合は cu126 に変更:

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126

※ ただし、公式PyTorchはまだ cu126 の whl を安定提供していないため、cu121 で十分なことが多いです。FramePack の cu126 という記載はビルド環境名に近い場合もあります。

再チェック後に実行 インストール後、以下で確認:

import torch

print(torch.version.cuda)

print(torch.cuda.is_available())

出力がたとえば:

12.1

True

PyTorchをアンインストール。

>pip uninstall torch

Found existing installation: torch 2.7.1

Uninstalling torch-2.7.1:

Would remove:

c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages\functorch\*

c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages\torch-2.7.1.dist-info\*

c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages\torch\*

c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages\torchgen\*

c:\users\user-name\appdata\local\programs\python\python310\scripts\torchfrtrace.exe

c:\users\user-name\appdata\local\programs\python\python310\scripts\torchrun.exe

CUDA 12.1対応の PyTorch をインストール(FramePack の cu126 に対応)

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

>pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu121

Looking in indexes: https://download.pytorch.org/whl/cu121

Collecting torch

Downloading https://download.pytorch.org/whl/cu121/torch-2.5.1%2Bcu121-cp310-cp310-win_amd64.whl (2449.4 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 2.4/2.4 GB 36.3 MB/s eta 0:00:00

Requirement already satisfied: torchvision in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (0.22.1)

Collecting torchaudio

Downloading https://download.pytorch.org/whl/cu121/torchaudio-2.5.1%2Bcu121-cp310-cp310-win_amd64.whl (4.1 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 4.1/4.1 MB 82.4 MB/s eta 0:00:00

Requirement already satisfied: filelock in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch) (3.18.0)

Requirement already satisfied: typing-extensions>=4.8.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch) (4.13.2)

Requirement already satisfied: networkx in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch) (3.4.2)

Requirement already satisfied: jinja2 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch) (3.1.6)

Requirement already satisfied: fsspec in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torch) (2025.5.1)

Collecting sympy==1.13.1 (from torch)

Downloading https://download.pytorch.org/whl/sympy-1.13.1-py3-none-any.whl (6.2 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 6.2/6.2 MB 76.0 MB/s eta 0:00:00

Requirement already satisfied: mpmath<1.4,>=1.1.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from sympy==1.13.1->torch) (1.3.0)

Requirement already satisfied: numpy in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torchvision) (2.2.6)

INFO: pip is looking at multiple versions of torchvision to determine which version is compatible with other requirements. This could take a while.

Collecting torchvision

Downloading https://download.pytorch.org/whl/cu121/torchvision-0.20.1%2Bcu121-cp310-cp310-win_amd64.whl (6.1 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 6.1/6.1 MB 74.4 MB/s eta 0:00:00

Requirement already satisfied: pillow!=8.3.*,>=5.3.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from torchvision) (10.1.0)

Requirement already satisfied: MarkupSafe>=2.0 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from jinja2->torch) (3.0.2)

Installing collected packages: sympy, torch, torchvision, torchaudio

Attempting uninstall: sympy

Found existing installation: sympy 1.14.0

Uninstalling sympy-1.14.0:

Successfully uninstalled sympy-1.14.0

Attempting uninstall: torchvision

Found existing installation: torchvision 0.22.1

Uninstalling torchvision-0.22.1:

Successfully uninstalled torchvision-0.22.1

Successfully installed sympy-1.13.1 torch-2.5.1+cu121 torchaudio-2.5.1+cu121 torchvision-0.20.1+cu121

冒頭にチェック用コードを追加テスト

import torch

print(torch.version.cuda)

print(torch.cuda.is_available())

>python run_framepack.py

12.1

True

ok

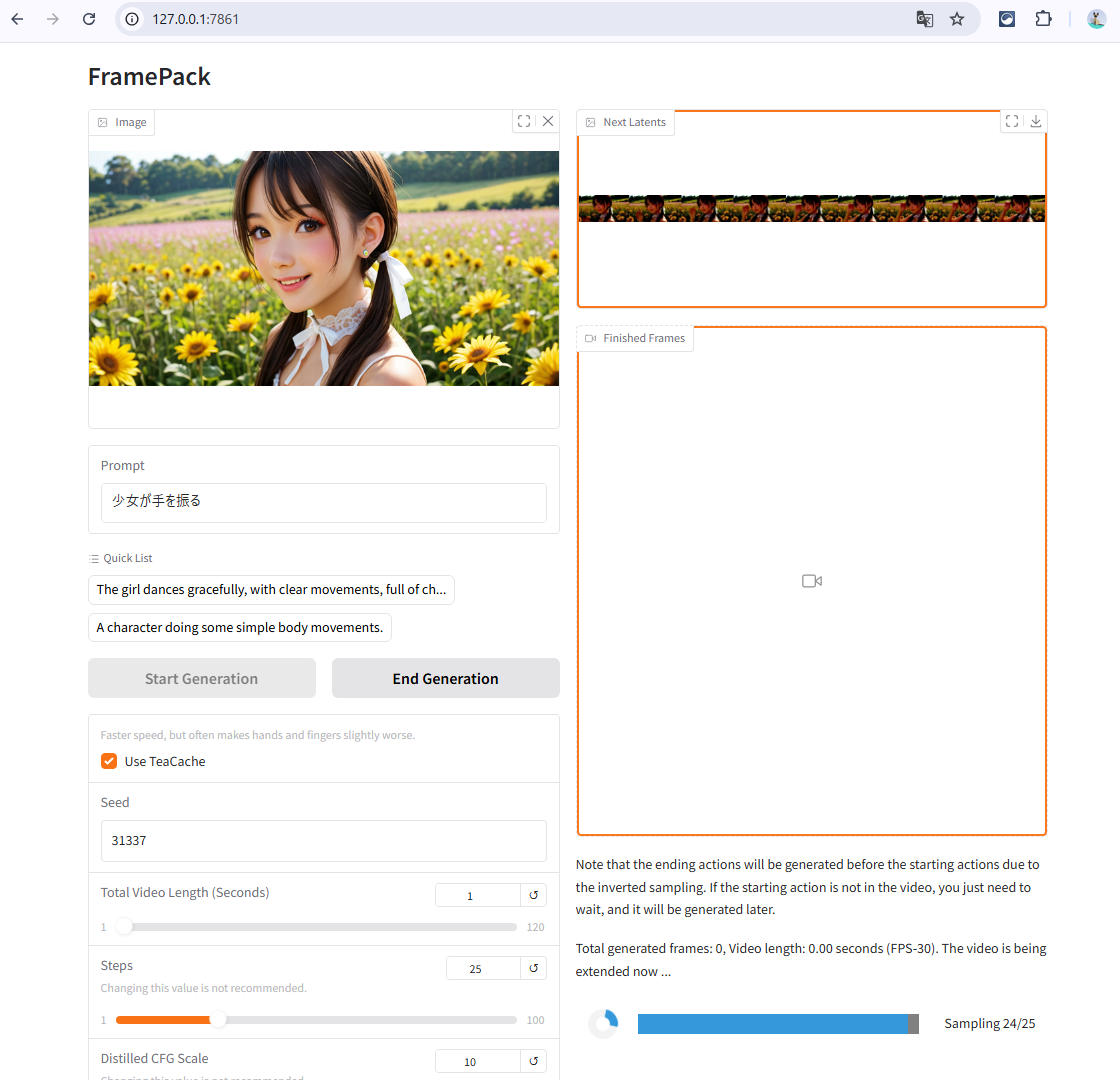

run_framepack.py経由でWebUIを起動

うごいた? でもこのログを見ると、サーバが起動してる時と同じように見えますね。

>python run_framepack.py

12.1

True

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 5, in <module>

sys.exit()

NameError: name 'sys' is not defined

C:\AI\framepack_cu126_torch26\webui>python run_framepack.py

Currently enabled native sdp backends: ['flash', 'math', 'mem_efficient', 'cudnn']

Xformers is not installed!

Flash Attn is not installed!

Sage Attn is not installed!

Namespace(share=False, server='0.0.0.0', port=None, inbrowser=False)

Free VRAM 10.779296875 GB

High-VRAM Mode: False

Loading checkpoint shards: 100%|██████████████████████████████████████████████████████████████████████████████████| 4/4 [00:00<00:00, 160.87it/s]

Fetching 3 files: 100%|████████████████████████████████████████████████████████████████████████████████████████████████████| 3/3 [00:00<?, ?it/s]

Loading checkpoint shards: 100%|███████████████████████████████████████████████████████████████████████████████████| 3/3 [00:00<00:00, 23.21it/s]

transformer.high_quality_fp32_output_for_inference = True

* Running on local URL: http://0.0.0.0:7861

* To create a public link, set `share=True` in `launch()`.

✨✨ ついに動きましたね!! ✨✨ おめでとうございます、これは FramePack の WebUI サーバーが起動に成功したログ です!

🔍 なぜCLIじゃなくてWebUIが起動したのか? 今回の run_framepack.py は、demo_gradio.py 経由の依存が残っているため、最終的に Gradio UI を起動 するルートを通っています。

もし 完全にCLIだけで実行させたい のであれば、demo_gradio.py の代わりに:

worker() 関数を直接呼び出し、

その 戻り値の画像 or 動画を保存 するようなコードを書く必要があります。

🎯 つまり今の状態は: ✅ FramePackの本体は問題なく動作中

✅ CUDAも正しく有効

✅ 必要なモデルもロード成功

✅ WebUIが使用可能(http://localhost:7861)

PyAV をインストール

折角自作スクリプトrun_framepack.pyから動いたので、動画を生成テストしてみます。

画像を設定し、確認用なので動画の長さは1秒に設定。

ただ、動画生成処理の最後に、エラー。

アウトプットファイル名関連の設定が無いせい?

Unloaded DynamicSwap_LlamaModel as complete.

Unloaded CLIPTextModel as complete.

Unloaded SiglipVisionModel as complete.

Unloaded AutoencoderKLHunyuanVideo as complete.

Unloaded DynamicSwap_HunyuanVideoTransformer3DModelPacked as complete.

Loaded CLIPTextModel to cuda:0 as complete.

Unloaded CLIPTextModel as complete.

Loaded AutoencoderKLHunyuanVideo to cuda:0 as complete.

Unloaded AutoencoderKLHunyuanVideo as complete.

Loaded SiglipVisionModel to cuda:0 as complete.

latent_padding_size = 0, is_last_section = True

Unloaded SiglipVisionModel as complete.

Moving DynamicSwap_HunyuanVideoTransformer3DModelPacked to cuda:0 with preserved memory: 6 GB

100%|████████████████████████████████████████████████████████████████████████████████████████████████████████████| 25/25 [03:32<00:00, 8.50s/it]

Offloading DynamicSwap_HunyuanVideoTransformer3DModelPacked from cuda:0 to preserve memory: 8 GB

Loaded AutoencoderKLHunyuanVideo to cuda:0 as complete.

Unloaded AutoencoderKLHunyuanVideo as complete.

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\demo_gradio.py", line 298, in worker

save_bcthw_as_mp4(history_pixels, output_filename, fps=30, crf=mp4_crf)

File "C:\AI\framepack_cu126_torch26\webui\diffusers_helper\utils.py", line 279, in save_bcthw_as_mp4

torchvision.io.write_video(output_filename, x, fps=fps, video_codec='libx264', options={'crf': str(int(crf))})

File "C:\Users\user-name\AppData\Local\Programs\Python\Python310\lib\site-packages\torchvision\io\video.py", line 90, in write_video

_check_av_available()

File "C:\Users\user-name\AppData\Local\Programs\Python\Python310\lib\site-packages\torchvision\io\video.py", line 41, in _check_av_available

raise av

ImportError: PyAV is not installed, and is necessary for the video operations in torchvision.

See https://github.com/mikeboers/PyAV#installation for instructions on how to

install PyAV on your system.

Unloaded DynamicSwap_LlamaModel as complete.

Unloaded CLIPTextModel as complete.

Unloaded SiglipVisionModel as complete.

Unloaded AutoencoderKLHunyuanVideo as complete.

Unloaded DynamicSwap_HunyuanVideoTransformer3DModelPacked as complete.

エラーの原因はズバリ:

❌ PyAV が未インストールで torchvision.io.write_video() が失敗したためです。

ImportError: PyAV is not installed, and is necessary for the video operations in torchvision.

See https://github.com/mikeboers/PyAV#installation

✅ 解決方法 以下のコマンドで PyAV をインストールすれば解決します:

pip install av

※ av という名前で PyPI に登録されており、pyav ではないので注意!

🔍 なぜ必要?

FramePack は torchvision.io.write_video() を使って MP4 動画を保存しており、 その内部で FFmpeg のPythonバインディング(=PyAV) を利用しています。

つまり:

worker() → save_bcthw_as_mp4() → torchvision.io.write_video() → PyAVが必要

✅ 補足:PyAV インストールでトラブルになりやすい場合 古いPythonやtorch/torchvision環境だとビルドに失敗することがあります

その場合は以下のように –upgrade を付けて実行

pip install --upgrade av

修正: utils.py -> save_bcthw_as_mp4()

>pip install av

Collecting av

Downloading av-14.4.0-cp310-cp310-win_amd64.whl.metadata (4.7 kB)

Downloading av-14.4.0-cp310-cp310-win_amd64.whl (27.9 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 27.9/27.9 MB 76.9 MB/s eta 0:00:00

Installing collected packages: av

Successfully installed av-14.4.0

別のエラー:TypeError: an integer is required。

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\demo_gradio.py", line 298, in worker

save_bcthw_as_mp4(history_pixels, output_filename, fps=30, crf=mp4_crf)

File "C:\AI\framepack_cu126_torch26\webui\diffusers_helper\utils.py", line 279, in save_bcthw_as_mp4

torchvision.io.write_video(output_filename, x, fps=fps, video_codec='libx264', options={'crf': str(int(crf))})

File "C:\Users\user-name\AppData\Local\Programs\Python\Python310\lib\site-packages\torchvision\io\video.py", line 140, in write_video

frame.pict_type = "NONE"

File "av/video/frame.pyx", line 216, in av.video.frame.VideoFrame.pict_type.__set__

TypeError: an integer is required

ありがとうございます。

このエラーは、torchvision.io.write_video() に渡している動画フレームのデータ(テンソル)の 型や構造に問題がある ことで発生する典型的なエラーです。

エラーの本質

frame.pict_type = "NONE"

TypeError: an integer is required

これは PyAV(avライブラリ)が VideoFrame.pict_type に “NONE”(文字列)を渡されて困ってるというより、内部でテンソルの構造やdtypeが 予期していない型になってる ために、PyAV がフレームの生成処理で失敗していることを示しています。

✅ 原因:torchvision.io.write_video() に渡すテンソルの条件 以下の3条件を満たしていないと、失敗します:

| 条件 | 説明 |

|---|---|

| dtype | uint8(整数型)である必要あり |

| shape | (num_frames, height, width, 3)(色順はRGB) |

| 値の範囲 | [0, 255] でなければならない |

修正案(変換処理を追加) save_bcthw_as_mp4() の直前に以下のような変換を入れてください:

import torch

# x: Tensor, shape=(batch, channel, time, height, width) → (time, height, width, channel)

x = history_pixels.permute(2, 3, 4, 1).contiguous() # BCTHW → T H W C

# 0〜1のfloat → 0〜255のuint8へ

x = (x * 255.0).clamp(0, 255).to(torch.uint8)

そしてその x を write_video() に渡します:

torchvision.io.write_video(output_filename, x, fps=fps, video_codec='libx264', options={'crf': str(int(crf))})

該当箇所のファイル

# diffusers_helper/utils.py の save_bcthw_as_mp4()

この関数の内部で x に上記の変換を追加するのが確実です。

✅ まとめ

- TypeError: an integer is required は PyAV がテンソルのdtypeや構造を正しく解釈できなかった結果

- .permute() + .clamp() + .to(torch.uint8) の追加で解決

- おそらく history_pixels は float32 かつ [0, 1] のままだった

とても良い質問です!結論から言うと:

✅ 今回の save_bcthw_as_mp4() の修正は、WebUI版にも安全 です。

🔍 理由(技術的に) diffusers_helper/utils.py の save_bcthw_as_mp4() 関数は、 CLI でも WebUI でも 共通で呼び出される補助関数です。

そして元のコードでもこのような変換がされています:

x = x.clamp(-1., 1.) * 127.5 + 127.5

x = x.detach().cpu().to(torch.uint8)

これがいわば「float32(-1.0~1.0)→ uint8(0~255)」への変換です。 したがって、もし history_pixels が [-1,1] スケールではなく [0,1] スケールだった場合、出力が破綻します。

✅ 安全な修正例(WebUI・CLI 両対応) あなたが提示したエラーを防ぎつつ、既存の処理と衝突しない形にできます:

# 現在の変換(-1〜1 から 0〜255 の uint8 へ)

x = x.clamp(-1., 1.) * 127.5 + 127.5

x = x.detach().cpu().to(torch.uint8)

# 代わりに両方対応できるよう条件チェックを入れる

if x.max() <= 1.0: # [0, 1] スケールと判断

x = x.clamp(0, 1) * 255.0

else: # [-1, 1] スケールと判断(従来の仕様)

x = x.clamp(-1., 1.) * 127.5 + 127.5

x = x.detach().cpu().to(torch.uint8)

📌 補足:WebUIでは「x」のスケールが[-1, 1]、CLIでは[0, 1]の可能性

- WebUI は vae.decode() 経由で float値が生成されており、clip後に [-1,1] スケールになる設計が多いです

- CLIで worker() を単独呼び出す場合、途中の正規化が抜けている可能性あり → [0, 1] になることも

✅ 結論(今後のメンテの視点)

- save_bcthw_as_mp4() に上記の if 条件つき変換を入れるのが最も安全

- CLIとWebUIの両方の入力に対応できる

- 他の副作用は基本的に起きない(ただし動作確認は一応推奨)

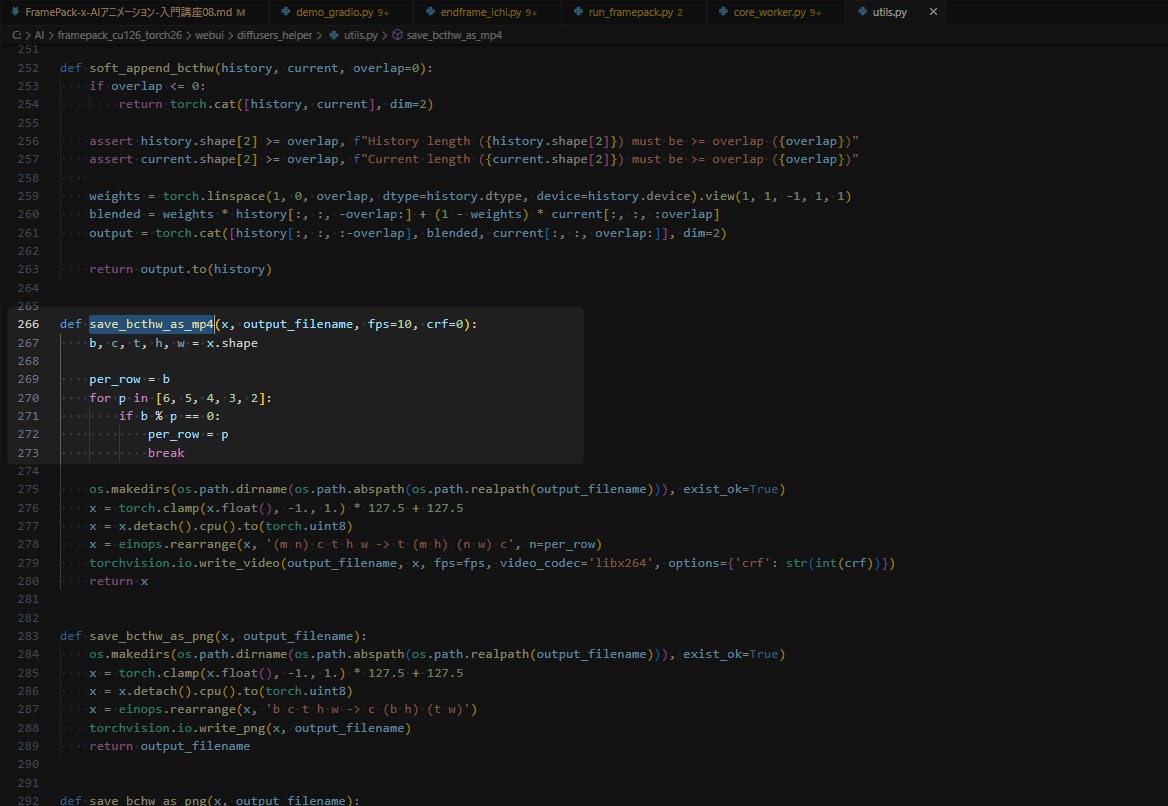

ありがとうございます。 現在、save_bcthw_as_mp4関数は以下のようになっていますが、最終的にどのように変更したらいいでしょうか?

def save_bcthw_as_mp4(x, output_filename, fps=10, crf=0):

b, c, t, h, w = x.shape

per_row = b

for p in [6, 5, 4, 3, 2]:

if b % p == 0:

per_row = p

break

os.makedirs(os.path.dirname(os.path.abspath(os.path.realpath(output_filename))), exist_ok=True)

x = torch.clamp(x.float(), -1., 1.) * 127.5 + 127.5

x = x.detach().cpu().to(torch.uint8)

x = einops.rearrange(x, '(m n) c t h w -> t (m h) (n w) c', n=per_row)

torchvision.io.write_video(output_filename, x, fps=fps, video_codec='libx264', options={'crf': str(int(crf))})

return x

✅ 修正済みの save_bcthw_as_mp4() 関数

def save_bcthw_as_mp4(x, output_filename, fps=10, crf=0):

b, c, t, h, w = x.shape

per_row = b

for p in [6, 5, 4, 3, 2]:

if b % p == 0:

per_row = p

break

os.makedirs(os.path.dirname(os.path.abspath(os.path.realpath(output_filename))), exist_ok=True)

# スケール判定と変換(CLIで0〜1、WebUIで-1〜1の可能性あり)

if x.max() <= 1.0:

# [0, 1] スケール(おそらく CLI 実行)

x = x.clamp(0., 1.) * 255.0

else:

# [-1, 1] スケール(WebUI経由など)

x = x.clamp(-1., 1.) * 127.5 + 127.5

x = x.detach().cpu().to(torch.uint8)

x = einops.rearrange(x, '(m n) c t h w -> t (m h) (n w) c', n=per_row)

torchvision.io.write_video(output_filename, x, fps=fps, video_codec='libx264', options={'crf': str(int(crf))})

return x

🔍 修正内容の意図

| 修正箇所 | 説明 |

|---|---|

if x.max() <= 1.0: |

画像のスケールを自動判別(0~1 or -1~1) |

x.clamp() の分岐 |

スケールに応じて正しい変換処理を実行 |

.cpu().to(torch.uint8) |

PyAV互換のため uint8 に変換 |

✅ この修正でできること

- WebUIの通常使用(GUI経由)でも問題なし

- CLIで run_framepack.py 実行時も変換成功

- 不正なスケールでも破綻しない

- CLIでの「TypeError: an integer is required」エラーを回避

必要に応じて、この処理の下に print(x.shape) を一時的に追加してデバッグも可能です。

問題なければ、このまま utils.py に反映してOKです!

save_bcthw_as_mp4を指定内容に変更後、再起動して、動画生成後、以下のエラー。

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\demo_gradio.py", line 298, in worker

save_bcthw_as_mp4(history_pixels, output_filename, fps=30, crf=mp4_crf)

File "C:\AI\framepack_cu126_torch26\webui\diffusers_helper\utils.py", line 287, in save_bcthw_as_mp4

torchvision.io.write_video(output_filename, x, fps=fps, video_codec='libx264', options={'crf': str(int(crf))})

File "C:\Users\user-name\AppData\Local\Programs\Python\Python310\lib\site-packages\torchvision\io\video.py", line 140, in write_video

frame.pict_type = "NONE"

File "av/video/frame.pyx", line 216, in av.video.frame.VideoFrame.pict_type.__set__

ありがとうございます。 表示されたエラーは以前と同じ TypeError: an integer is required に関連しており、PyAV 側で VideoFrame.pict_type に不正な値が入っている可能性を示しています。

✅ エラーの発生箇所(再掲)

File ".../video.py", line 140, in write_video

frame.pict_type = "NONE"

File "av/video/frame.pyx", line 216, in av.video.frame.VideoFrame.pict_type.__set__

TypeError: an integer is required

🔍 原因と対処 このエラーは、PyTorch + TorchVision + PyAV の torchvision.io.write_video() に渡されるテンソル x の データ形式 or 次元数の不一致 が原因であることがほとんどです。

▶ おそらくの原因 einops.rearrange() で生成されたテンソル x の dtype・shape に問題がある

または、uint8 にした後に numpy 変換を経ていない可能性

✅ 修正案:x を NumPy に変換して渡す torchvision.io.write_video() の仕様では、PyTorchのテンソルではなく NumPy array を渡すと安定する という報告が複数あります。

🔧 修正する行(utils.py の save_bcthw_as_mp4)

x = x.detach().cpu().to(torch.uint8).numpy() # NumPy に変換

🔄 修正済みの一部抜粋(下部だけ)

x = x.detach().cpu().to(torch.uint8)

x = einops.rearrange(x, '(m n) c t h w -> t (m h) (n w) c', n=per_row)

x = x.numpy() # ← この行を追加(PyTorch Tensor → NumPy Array)

torchvision.io.write_video(

output_filename, x, fps=fps,

video_codec='libx264',

options={'crf': str(int(crf))}

)

✅ まとめ

| 項目 | 内容 |

|---|---|

| 問題 | pict_type に PyAV が整数を期待してるのに文字列が渡ってしまう |

| 原因 | torch.Tensor から NumPy に変換してないため |

| 解決 | .numpy() を最後に明示的に加えることで write_video() の挙動が安定 |

これで save_bcthw_as_mp4() のエラーはかなりの確率で解消されるはずです。 お試しいただき、再度 run_framepack.py で動作を確認してみてください。

再起動して試しましたが、まだエラーが出るようです。

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\demo_gradio.py", line 298, in worker

save_bcthw_as_mp4(history_pixels, output_filename, fps=30, crf=mp4_crf)

File "C:\AI\framepack_cu126_torch26\webui\diffusers_helper\utils.py", line 289, in save_bcthw_as_mp4

torchvision.io.write_video(output_filename, x, fps=fps, video_codec='libx264', options={'crf': str(int(crf))})

File "C:\Users\user-name\AppData\Local\Programs\Python\Python310\lib\site-packages\torchvision\io\video.py", line 140, in write_video

frame.pict_type = "NONE"

File "av/video/frame.pyx", line 216, in av.video.frame.VideoFrame.pict_type.__set__

ありがとうございます。ご報告のとおり、torchvision.io.write_video() を通して PyAV 側で frame.pict_type = “NONE” を内部的に行おうとして失敗している典型的なエラーです。

❌ エラーの原因(再確認) PyAV は VideoFrame.pict_type に「整数型(AVPictureType)」しか受け付けません。 しかし、内部で “NONE”(文字列)を渡そうとして TypeError が発生しています。

この問題は以下の条件でよく見られます:

- torchvision のバージョンと PyAV のバージョンに 互換性がない

- write_video() に渡す データ型や shape が不正

- ffmpeg とのビルド環境不一致(特に Windows)

✅ 解決策(確実性順) ✅ ① write_video() を避け、代わりに imageio + ffmpeg を使う

PyAV/torchvision の write_video() は非常に不安定なため、CLI用途では以下に置き換えるのが安全です:

🔁 置換案:save_bcthw_as_mp4() 全体の代替コード(ffmpeg + imageio)

import imageio.v2 as imageio

import numpy as np

def save_bcthw_as_mp4(x, output_filename, fps=10, crf=0):

b, c, t, h, w = x.shape

os.makedirs(os.path.dirname(os.path.abspath(os.path.realpath(output_filename))), exist_ok=True)

x = torch.clamp(x.float(), -1., 1.) * 127.5 + 127.5

x = x.detach().cpu().to(torch.uint8)

x = einops.rearrange(x, '(m n) c t h w -> t (m h) (n w) c', n=b) # t h w c

frames = x.numpy()

writer = imageio.get_writer(output_filename, fps=fps, codec='libx264', quality=None, ffmpeg_params=['-crf', str(crf)])

for frame in frames:

writer.append_data(frame)

writer.close()

return x

✅ ② PyTorch torchvision のバージョンを変更する(非推奨だが有効) torchvision==0.14.1(古いが安定)と PyAV==10.0.0 あたりに揃えると治るケースが報告されています:

pip uninstall torchvision

pip install torchvision==0.14.1

pip uninstall av

pip install av==10.0.0

ただし、環境全体の整合性が崩れる可能性があるため、非推奨です。

✅ ③ pict_type を使わせないように回避(応急処置)

こちらは torchvision の内部実装依存なので、上記①の方が確実です。

✅ 推奨:imageio + ffmpeg による動画書き出し

Windows 環境でも安定して動作

高速かつ crf 指定も可能

FramePack のCLI版や自動化用途に最適

コードを書き替えた際に、「imageio」のところでオレンジの波線が出てたので(VSCode警告?注意?)、モジュールか何かが必要なんでしょうね。

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\demo_gradio.py", line 298, in worker

save_bcthw_as_mp4(history_pixels, output_filename, fps=30, crf=mp4_crf)

File "C:\AI\framepack_cu126_torch26\webui\diffusers_helper\utils.py", line 275, in save_bcthw_as_mp4

writer = imageio.get_writer(output_filename, fps=fps, codec='libx264', quality=None, ffmpeg_params=['-crf', str(crf)])

NameError: name 'imageio' is not defined. Did you mean: 'Image'?

そのエラーはまさにお察しの通りで、以下の理由です:

❌ エラー内容

NameError: name 'imageio' is not defined. Did you mean: 'Image'?

- 原因:imageio を importしていない

- または pip install imageio を していない

✅ 解決手順 ① 必要なライブラリをインストール(初回のみ) 以下を実行してください(ffmpeg も自動で組み込まれます):

pip install imageio[ffmpeg]

または、より確実に:

pip install imageio imageio-ffmpeg

② ファイル冒頭に import を追加 diffusers_helper/utils.py の先頭(または save_bcthw_as_mp4() の上)に:

import imageio.v2 as imageio

✅ オレンジ波線について(VSCode)

- オレンジや黄色の波線は 未定義/未インポートまたは未解決の警告

- 通常、import imageio が不足している時に出ます

🔁 再確認:修正済み save_bcthw_as_mp4()(再掲)

import os

import imageio.v2 as imageio

import torch

import einops

def save_bcthw_as_mp4(x, output_filename, fps=10, crf=0):

b, c, t, h, w = x.shape

os.makedirs(os.path.dirname(os.path.abspath(os.path.realpath(output_filename))), exist_ok=True)

x = torch.clamp(x.float(), -1., 1.) * 127.5 + 127.5

x = x.detach().cpu().to(torch.uint8)

x = einops.rearrange(x, '(m n) c t h w -> t (m h) (n w) c', n=b)

frames = x.numpy()

writer = imageio.get_writer(output_filename, fps=fps, codec='libx264',

quality=None, ffmpeg_params=['-crf', str(crf)])

for frame in frames:

writer.append_data(frame)

writer.close()

return x

これで、torchvision の write_video() を完全に回避できます。 成功すれば、CLIでのFramePack動作も実用段階に入ります。

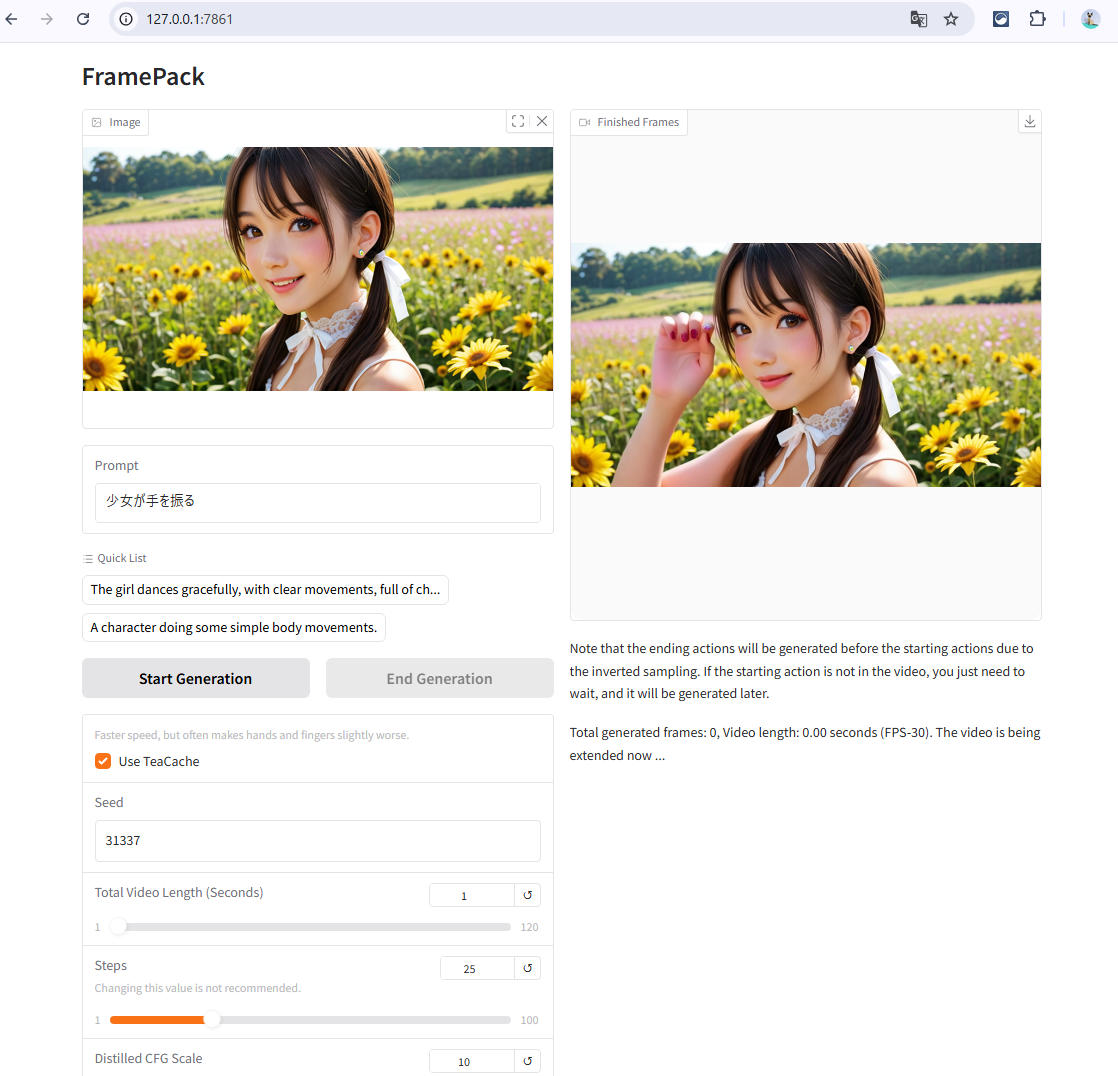

WebUI経由で動画生成に成功

>pip install imageio imageio-ffmpeg

Collecting imageio

Using cached imageio-2.37.0-py3-none-any.whl.metadata (5.2 kB)

Collecting imageio-ffmpeg

Downloading imageio_ffmpeg-0.6.0-py3-none-win_amd64.whl.metadata (1.5 kB)

Requirement already satisfied: numpy in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from imageio) (2.2.6)

Requirement already satisfied: pillow>=8.3.2 in c:\users\user-name\appdata\local\programs\python\python310\lib\site-packages (from imageio) (10.1.0)

Using cached imageio-2.37.0-py3-none-any.whl (315 kB)

Downloading imageio_ffmpeg-0.6.0-py3-none-win_amd64.whl (31.2 MB)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ 31.2/31.2 MB 73.4 MB/s eta 0:00:00

Installing collected packages: imageio-ffmpeg, imageio

Successfully installed imageio-2.37.0 imageio-ffmpeg-0.6.0

今度は成功。

完成した動画。

動きました、ありがとうございます。

動画作るのに時間がかかるので別事やってました。

WebUIで動作するようになったので、あとは、CLIで動かすだけですね。

現在のコードは以下のようになってます。

「from demo_gradio import generate_timestamp」を外す?

その上で、コードの追加が必要?

# run_framepack.py

from PIL import Image

import numpy as np

import core_worker # Gradioに依存しない版

from demo_gradio import generate_timestamp

img = np.array(Image.open("framepack_cli_test/input.png").convert("RGB"))

core_worker.worker(

img,

prompt="少女が手を振る",

n_prompt="",

seed=1234,

total_second_length=5,

latent_window_size=9,

steps=25,

cfg=1.0,

gs=10.0,

rs=0.0,

gpu_memory_preservation=6,

use_teacache=True,

mp4_crf=16

)

CLI版の制作

動作成功、おめでとうございます!🎉

ついに FramePackのCLI動作 が目前ですね…!

✅ 現状のコード状況

現在の run_framepack.py は WebUI 連携用の generate_timestamp() をインポートしているため、demo_gradio に依存してしまっている状態 です。

CLI単体で動かすなら、demo_gradio の依存を完全に排除して、出力ファイル名なども自分で指定しましょう。

✅ 修正版 run_framepack.py(CLI専用化)

from PIL import Image

import numpy as np

import core_worker # Gradioに依存しないworker関数

import os

from datetime import datetime

# 出力フォルダの作成(存在しない場合)

os.makedirs("outputs", exist_ok=True)

# タイムスタンプでファイル名を生成

def generate_timestamp():

return datetime.now().strftime("%Y%m%d_%H%M%S")

# 入力画像の読み込み

img = np.array(Image.open("framepack_cli_test/input.png").convert("RGB"))

# 実行

core_worker.worker(

input_image=img,

prompt="少女が手を振る",

n_prompt="",

seed=1234,

total_second_length=5,

latent_window_size=9,

steps=25,

cfg=1.0,

gs=10.0,

rs=0.0,

gpu_memory_preservation=6,

use_teacache=True,

mp4_crf=16,

output_filename=f"outputs/framepack_cli_{generate_timestamp()}.mp4" # 追加!

)

✅ 補足ポイント

- output_filename の明示的指定は 必須:WebUIでは自動で補完されていましたが、CLIでは必ず渡す必要があります。

- generate_timestamp() は demo_gradio から分離:CLI向けに最低限の簡易バージョンを定義。

- outputs/ フォルダを自動作成:複数出力時に便利。

🚀 今後の展望

- 複数画像対応(順次バッチ処理)

- 複数プロンプトの一括試行

- WebUIとCLIの共存によるハイブリッド運用

このままいけば、FramePackのCLI完全動作が確定ですね。

生成が完了したら .mp4 が outputs/ フォルダに出力されるはずです。

確認できたら、ぜひブログにも反映してみてください!

run_framepack.pyを修正しました。

実行結果、argument ‘output_filename’と書かれてるので、引数がらみの問題ですね…。

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 19, in <module>

core_worker.worker(

File "C:\Users\user-name\AppData\Local\Programs\Python\Python310\lib\site-packages\torch\utils\_contextlib.py", line 116, in decorate_context

return func(*args, **kwargs)

TypeError: worker() got an unexpected keyword argument 'output_filename'

ありがとうございます、エラーメッセージから明確にわかるのは:

TypeError: worker() got an unexpected keyword argument ‘output_filename’

→ worker() 関数が output_filename を受け取るように設計されていない

✅ 対処方法

core_worker.py 内にある worker() 関数を開き、次のように output_filename を引数に追加してください。

🔧 core_worker.py 側の修正例:

@torch.no_grad()

def worker(

input_image,

prompt,

n_prompt,

seed,

total_second_length,

latent_window_size,

steps,

cfg,

gs,

rs,

gpu_memory_preservation,

use_teacache,

mp4_crf,

output_filename=None # ← この1行を追加!

):

# --- 中略(元の処理) ---

# 動画保存処理の直前あたりでこのように指定:

if output_filename is None:

output_filename = f"outputs/framepack_output_{generate_timestamp()}.mp4"

# 保存処理の呼び出し

save_bcthw_as_mp4(history_pixels, output_filename, fps=30, crf=mp4_crf)

✅ まとめ

| 項目 | 対応内容 |

|---|---|

| 原因 | worker() が output_filename を受け取らない |

| 修正方法 | core_worker.py の worker() に引数を追加 |

| 副作用について | 引数が無い場合は generate_timestamp() で自動生成 |

| 動作確認後の次の一手 | バッチ処理 or YAML設定連携による完全CLI実装 |

この変更を加えた後、再度 run_framepack.py を実行してみてください。

出力先が outputs/ フォルダに .mp4 として保存されるはずです。応援してます!

とても良い視点です。ご心配もっともですが、結論から言うと:

✅ worker() に引数を追加しても、WebUI版の動作に支障は出ません

(デフォルト値があれば)

🔍 理由の解説:

WebUI(demo_gradio.py)では worker() を以下のように呼び出しています:

history_pixels = worker(

input_image,

prompt,

n_prompt,

seed,

total_second_length,

latent_window_size,

steps,

cfg,

gs,

rs,

gpu_memory_preservation,

use_teacache,

mp4_crf

)

つまり output_filename は渡していないため、今回 worker() に追加する引数には デフォルト値(None など)をつければ OK です。

✅ 修正の安全な書き方:

def worker(

input_image,

prompt,

n_prompt,

seed,

total_second_length,

latent_window_size,

steps,

cfg,

gs,

rs,

gpu_memory_preservation,

use_teacache,

mp4_crf,

output_filename=None # ← 安全な追加

):

- None を初期値にすることで 既存の呼び出しはそのまま動作します

- CLIからのみ output_filename を使いたい場合も対応できます

✅ CLI版とWebUI版の共存ができる

- WebUI版:何も渡さずそのまま呼び出し → 自動生成されるファイル名で保存

- CLI版 :明示的に output_filename=“out.mp4” を渡して保存先指定

✨補足(さらに万全にするなら) 関数の末尾近くで output_filename を使う部分で:

if output_filename is None:

output_filename = f"outputs/framepack_output_{generate_timestamp()}.mp4"

としておけば、両方で問題なく使えます。

ご安心の上、ぜひ worker() に output_filename=None を加えてみてください。

何か動作に違和感があればいつでも見ます!

core_worker.pyを修正。

@torch.no_grad()

def worker(input_image, prompt, n_prompt, seed, total_second_length, latent_window_size, steps, cfg, gs, rs, gpu_memory_preservation, use_teacache, mp4_crf,output_filename=None):

スクショ:

ただ、NameError: name ‘generate_timestamp’ is not definedで、定義されてない云々。

インポートが必要?

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 19, in <module>

core_worker.worker(

File "C:\Users\user-name\AppData\Local\Programs\Python\Python310\lib\site-packages\torch\utils\_contextlib.py", line 116, in decorate_context

return func(*args, **kwargs)

File "C:\AI\framepack_cu126_torch26\webui\core_worker.py", line 15, in worker

job_id = generate_timestamp()

NameError: name 'generate_timestamp' is not defined

ありがとうございます。CLI版の worker() 実行時に以下のエラー:

NameError: name 'generate_timestamp' is not defined

✅ 原因

generate_timestamp() は demo_gradio.py 内で定義されている関数であり、core_worker.py 側では インポートされていないため、CLI実行時に NameError が出ています。

✅ 解決方法:generate_timestamp をインポート

あなたの core_worker.py の冒頭に以下の行を追加してください:

from demo_gradio import generate_timestamp

✅ 補足:将来的な再利用性を高めるには

generate_timestamp() を汎用関数とみなして、utils.py のような共通ユーティリティファイルに切り出しておくのもおすすめです。そうすれば、core_worker.py や demo_gradio.py の両方で同じ関数を共有できます。

動きましたが、ただ、またGUI版が立ち上がったようです。 from demo_gradio import generate_timestampのせいでしょうね。

>python run_framepack.py

Traceback (most recent call last):

File "C:\AI\framepack_cu126_torch26\webui\run_framepack.py", line 19, in <module>

core_worker.worker(

File "C:\Users\user-name\AppData\Local\Programs\Python\Python310\lib\site-packages\torch\utils\_contextlib.py", line 116, in decorate_context

return func(*args, **kwargs)

File "C:\AI\framepack_cu126_torch26\webui\core_worker.py", line 15, in worker

job_id = generate_timestamp()

NameError: name 'generate_timestamp' is not defined

C:\AI\framepack_cu126_torch26\webui>python run_framepack.py

Currently enabled native sdp backends: ['flash', 'math', 'mem_efficient', 'cudnn']

Xformers is not installed!

Flash Attn is not installed!

Sage Attn is not installed!

Namespace(share=False, server='0.0.0.0', port=None, inbrowser=False)

Free VRAM 10.779296875 GB

High-VRAM Mode: False