はじめに

2025年4月17日、AI界隈で著名なイリヤスフィール氏が、ローカル環境で動作する動画生成AI「FramePack」を発表し、AI界隈で話題になりました。

それまでの動画生成AIでは、ハイエンドなGPUを搭載したパソコン(特に多くのVRAMを積んでいるモデル)でなければ動作させる事が困難でしたが、FramePackは、VRAMが6GBの環境でも動画を作成できる点で注目を浴び評価され、生成AI界隈に新たな波を起こしています。

うちのPC環境では、GPUは NvidiaのRTX4070Ti(VRAM 12GB)を使用しており、FramePackの動作要件を満たしており、インストールから動画生成するまで手順を軽くまとめてみました。

FramePack の概要・特徴

- 画像1枚から最大120秒の動画生成可能

- 最低6GBのGPUメモリで動作

- TeaCacheを使用すれば1フレーム約1.5秒で生成可能

FramePack推奨スペック

| 項目 | 内容 |

|---|---|

| GPU | NVIDIA RTX 30XX / 40XX / 50XX |

| VRAM(GPUメモリ) | 最低6GB(生成速度は容量に比例) |

| OS | Windows 10 / 11 / Linux |

| Python | Version 3.10 |

| ストレージ | 65GB~(モデル含め約64GB) |

| メモリ(RAM) | 最低16GB(推奨は32~64GB) |

CPUは RTX3060をベースとしても最低 第10世代のIntel CPUがあった方が安心だと思います。

※13世代CPUに関しては、上位モデルで不都合の報告がある為、注意。

FramePack‑eichiとは

lllyasviel氏のFramePackをベースに、nirvash氏の改良版をさらに強化した動画生成AIフレームワークです。

■FramePack‑eichiの特徴

- 多言語対応 - 日本語、英語、繁体字中国語のUIをサポート

- 柔軟な動画長設定 - 1〜20秒の各セクションモードに対応

- セクションフレームサイズ設定 - 0.5秒モードと1秒モードを切り替え可能

- オールパディング機能 - すべてのセクションで同じパディング値を使用可能

FramePack-eichiの最大の特徴は、キーフレーム(複数設定可能)を設定できる事で、 動画の開始画像(必須)と終了画像に加えて、中間のキーフレームを設定することにより、アニメーションの流れを細かくコントロールすることが可能になります。

製作環境(PCスペック)

動作確認環境

| 項目 | 内容 |

|---|---|

| CPU: | Core i7-12700K |

| MB: | ASRock Z690 Steel Legend |

| MEM: | ArkARD4-U32G48HB-24R-D DDR4 64G |

| GPU: | GK-RTX4070Ti-E12GB/WHITE/TP |

FramePackで1秒(33フレーム)の動画を生成するのに1分30秒程度。

VRAMも重要ですが、メインメモリの容量も重要で 当初 32GBでしたが、画像生成AIを動かした際、解像度を上げるとメモリ不足になった経験があり、その際に容量アップしています。

FramePack‑eichiも同様に、生成時にはかなりメモリを消費します。

Stable Diffusionで画像生成

Stable Diffusionで画像生成し、作成した画像を、FramePack‑eichiを使ってアニメーション動画を作成して見ます。

Stable Diffusionのインストール方法は以下の記事でまとめています。

![[画像生成AI] Stable Diffusion Checkpoint 導入ガイド](https://humanxai.info/images/uploads/generative-AI_Stable-Diffusion-checkpoint-install.webp)

[画像生成AI] Stable Diffusion Checkpoint 導入ガイド

[画像生成AI] Stable Diffusion Checkpoint 導入ガイド

https://humanxai.info/posts/generative-ai_stable-diffusion-checkpoint-install/今回は、モデルに「CyberRealistic Pony(v10.0)」を使い、プロンプトはcivitaiで公開されている以下のページの物を使わせていただきました。

Image posted by bestzh

CyberRealistic Pony (v10.0) Checkpoint

https://civitai.com/images/77997835CyberRealistic Ponyとは?

莫大な追加学習が施された人気モデルで、主に、アニメ/イラスト系で大胆な構図などが特徴のモデルです。

画像は商用利用が可能ですが、いくつかの規約に注意が必要です。

Ponyモデルは「PurpleSmartAI」という開発者によってトレーニングされており、商用利用の際はクレジット表記が義務付けられています。

例:「generated by pony diffusion V6(trained by PurpleSmartAI)」

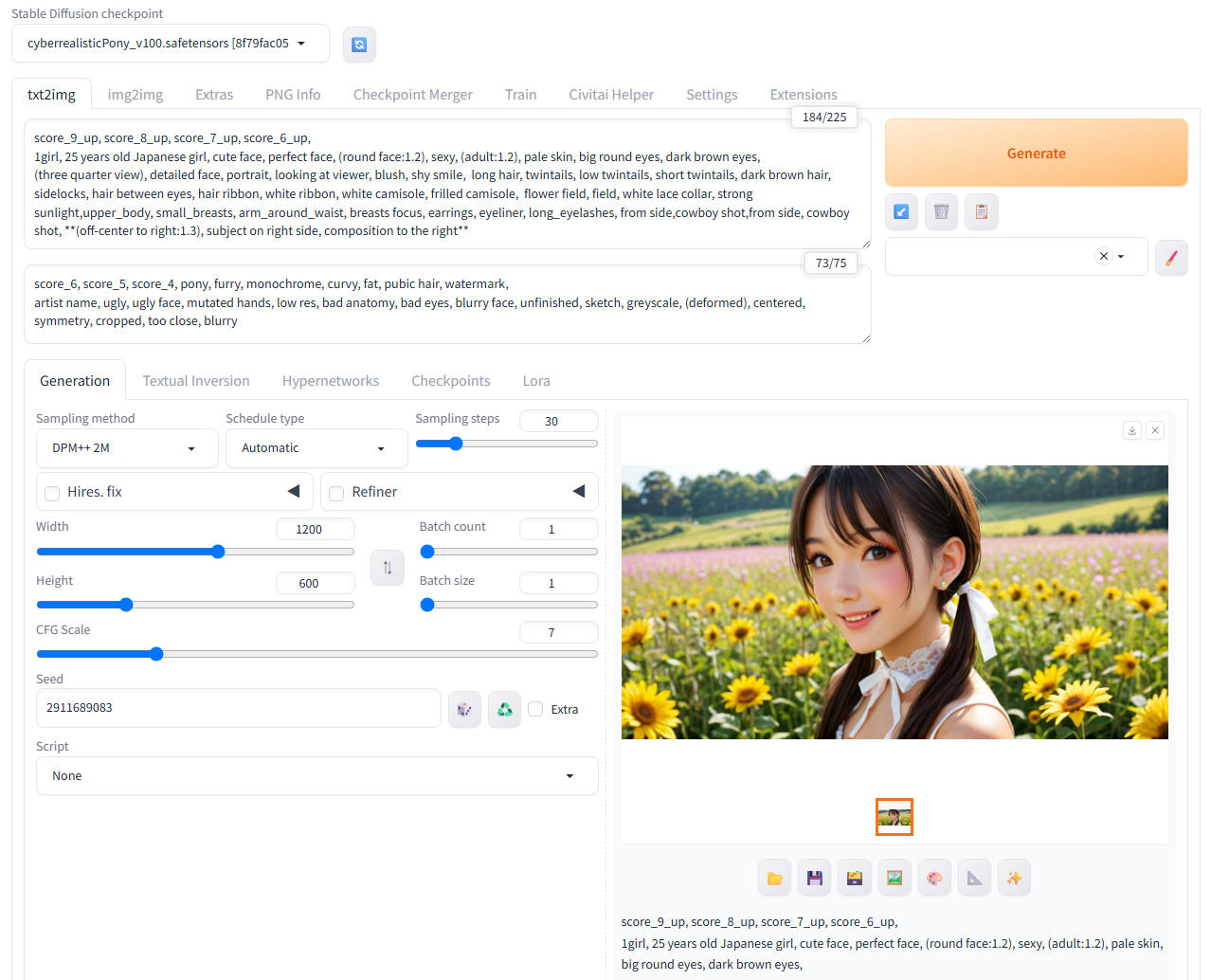

画像生成用のプロンプトを作成

若干、公式のプロンプトを追加修正しました。

Prompt:

score_9_up, score_8_up, score_7_up, score_6_up,

1girl, 25 years old Japanese girl, cute face, perfect face, (round face:1.2), sexy, (adult:1.2), pale skin, big round eyes, dark brown eyes,

(three quarter view), detailed face, portrait, looking at viewer, blush, shy smile, long hair, twintails, low twintails, short twintails, dark brown hair, sidelocks, hair between eyes, hair ribbon, white ribbon, white camisole, frilled camisole, flower field, field, white lace collar, strong sunlight,upper_body, small_breasts, arm_around_waist, breasts focus, earrings, eyeliner, long_eyelashes, from side,cowboy shot,from side, cowboy shot, **(off-center to right:1.3), subject on right side, composition to the right**

Negative prompt:

score_6, score_5, score_4, pony, furry, monochrome, curvy, fat, pubic hair, watermark,

artist name, ugly, ugly face, mutated hands, low res, bad anatomy, bad eyes, blurry face, unfinished, sketch, greyscale, (deformed),

Stable Diffusionで画像を生成

今回は、解像度は「 1200 x 600 px」 で、Sampling steps 「30」、Sampling method「DPM++ 2M」にしています。

上記の設定で、Generate ボタンを押して作成した画像は以下になります。

画像を見て分かる通り、pony系のモデルは非常に高品質な画像を生成する事が出来ます。

※FramePack‑eichiで動作確認用にダウンロードして使っていただいて構いません。

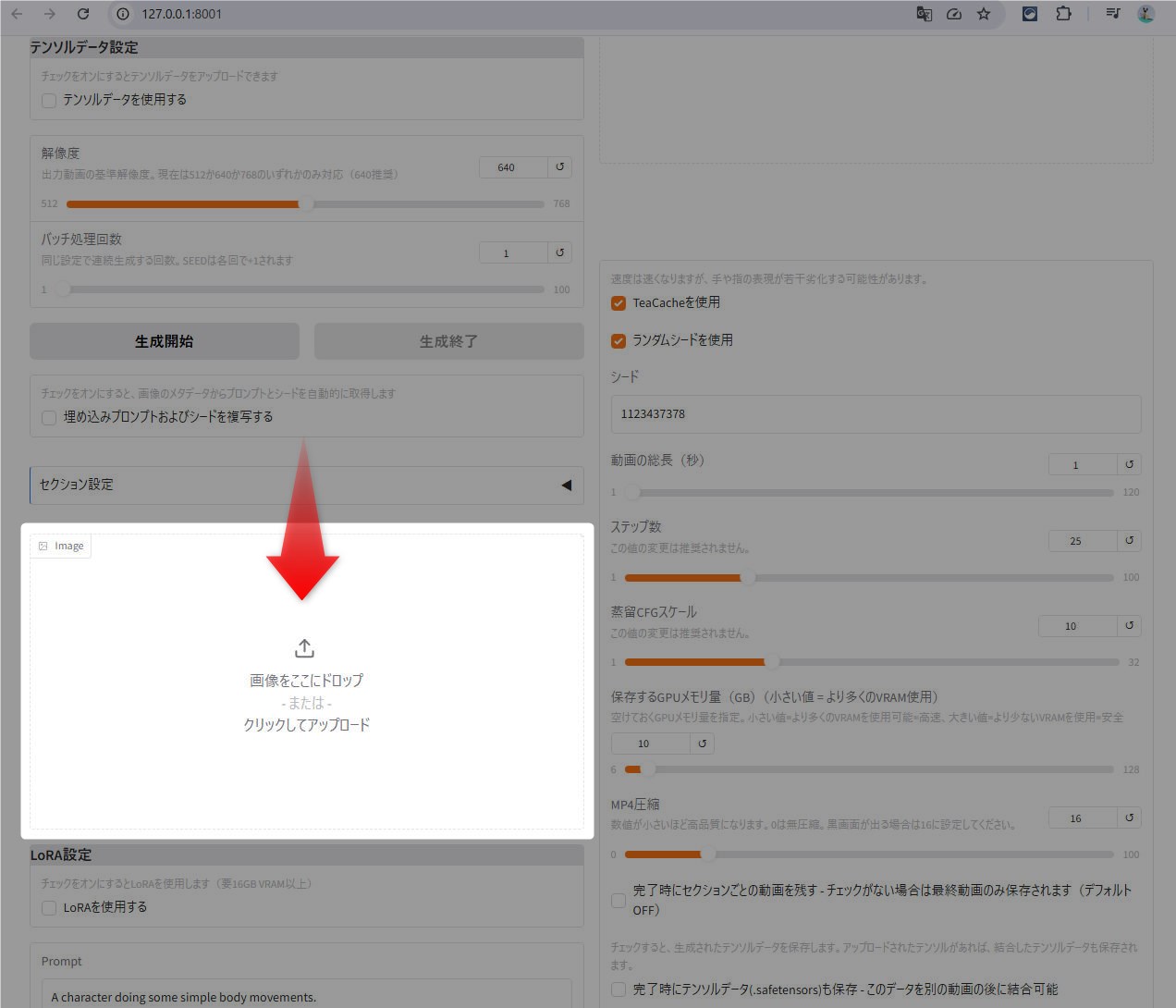

FramePack‑eichiで動画を生成

Stable Diffusionで作成した画像を使い、FramePack‑eichiでアニメーションしてみます。

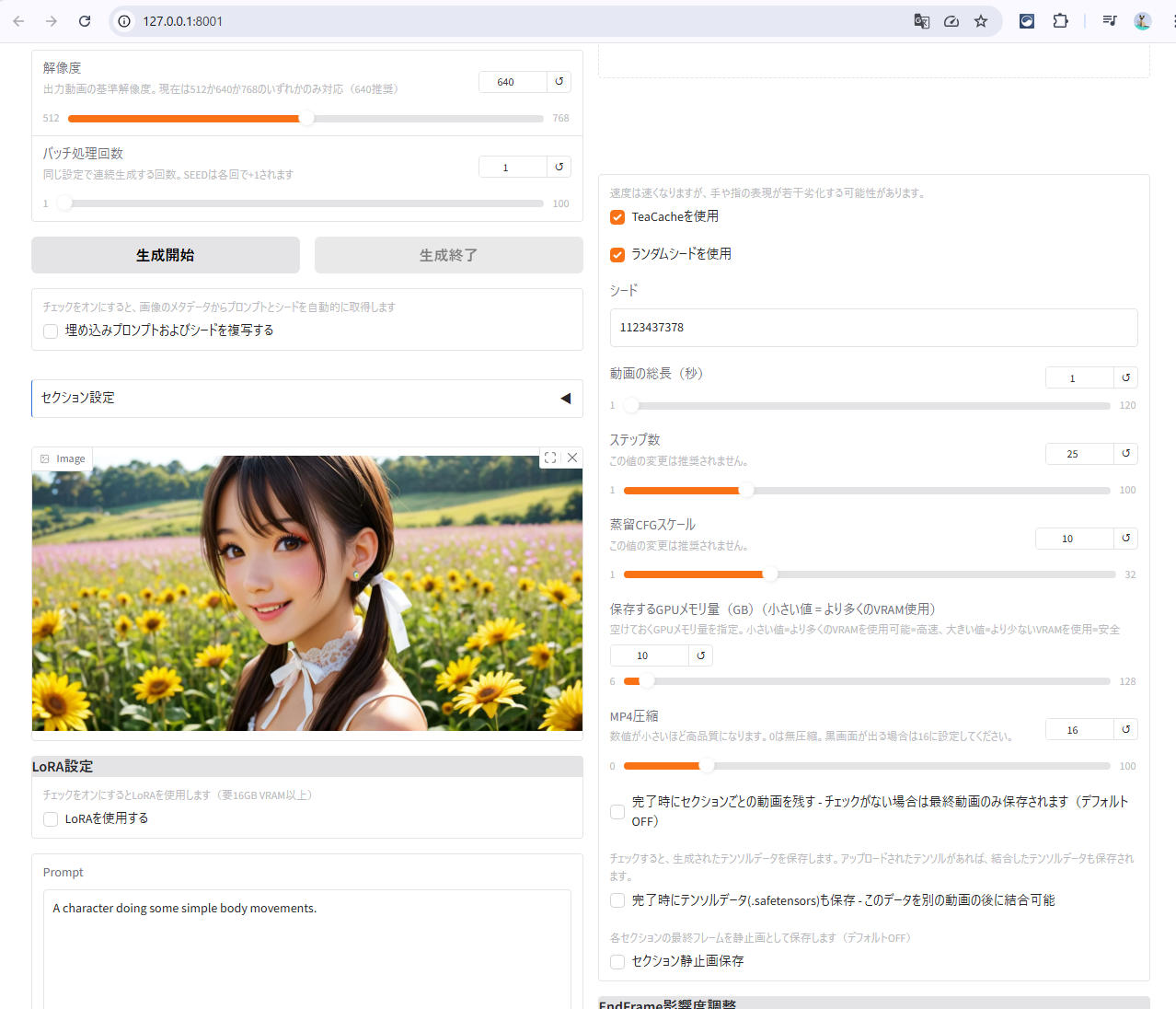

FramePack-eichiをローカル環境で起動させた後、画面を下にスクロールし、[image]タグのあるエリアに画像をドラッグアンドドロップ。

エリア内に画像が表示されたらOK。

次にプロンプトを入力。 デフォルトのままでもいいですが、今回は、 「ピースサインをしてウインクをする」 というプロンプトを設定して見ます。

画像をドロップした画面の下にある「Prompt」と表示された入力ボックスに、

Peace sign and wink

と入力。

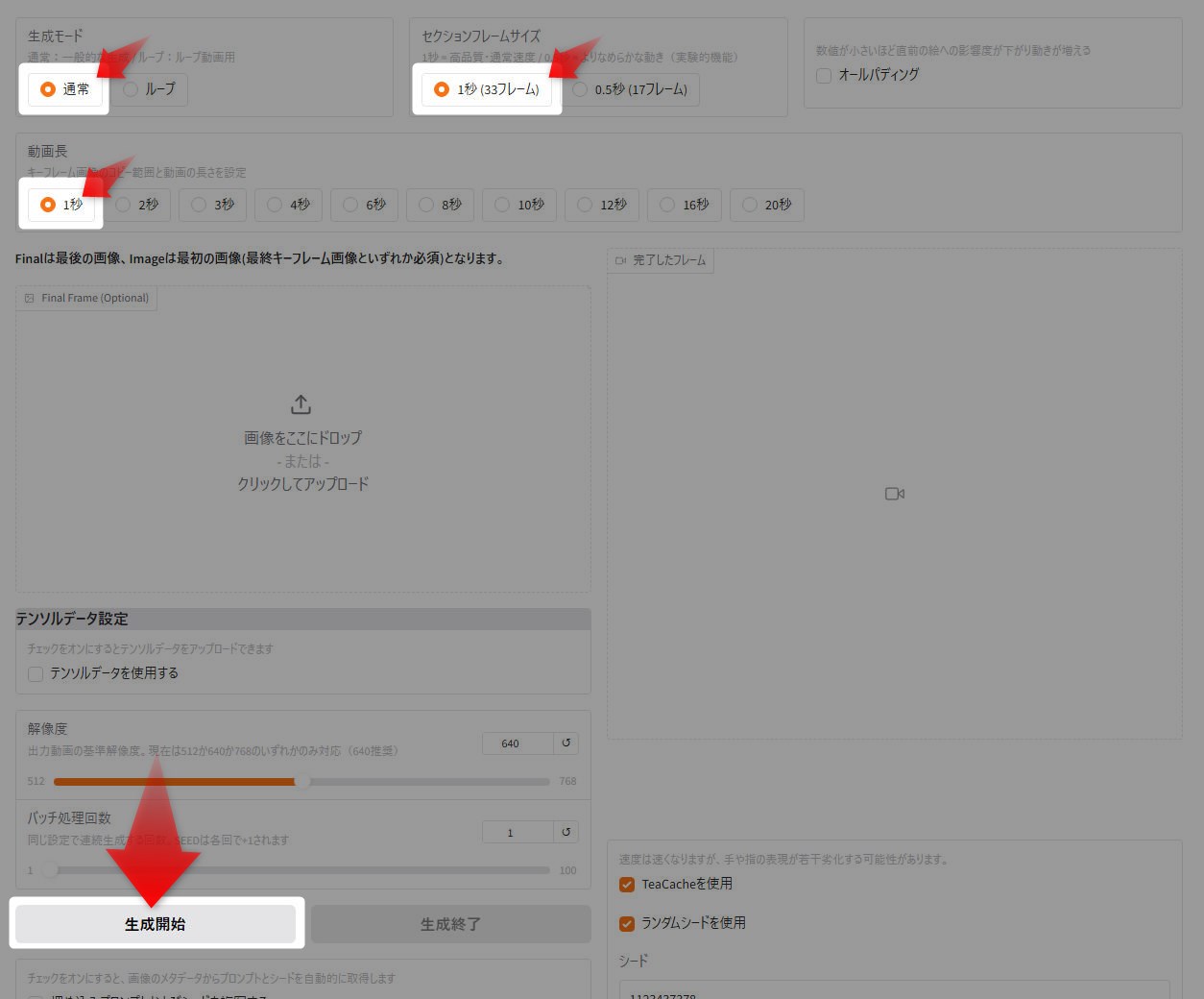

後はデフォルト設定のままでも良いですが、今回は、動作テストなので、直ぐ確認できるよう1秒の動画を作成して見ます。

画面を上にスクロールし、下の画像の項目をチェックし、最後に生成開始を押すと、動画が生成されます。

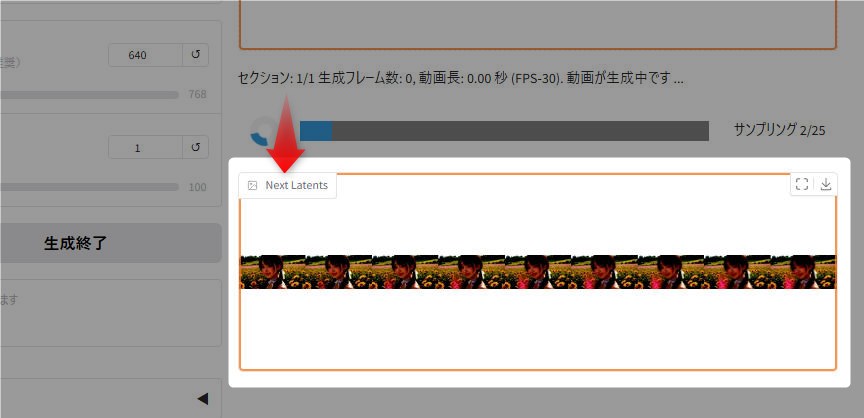

生成途中の流れは、「Next Latents」エリアで確認できますので、思うようなアニメーションにならない場合

動画生成が終了すると、画面右上の「完成したフレーム」で動画を確認できます。 フレーム内の右上にある「↓」ボタンで完成した動画をダウンロードできます。

その他、生成された動画は、ローカルディスク内のframepackをインストールしたフォルダにある

\webui\outputs

にも保存されますので、万が一、ダウンロード出来なかった場合は、ここを確認すればOKです。

削除しない場合、動画ファイルが溜まりディスク容量を圧迫しますので、定期削除や移動をした方がいいです。

AIアニメーションのデモ

以下はFramePack-eichiで生成したMP4動画のデモです。

FramePack‑eichi:現状の限界と特徴的な制約

以下は、AIに聞いた FramePack‑eichiの特徴と問題点など。

| 項目 | 内容 |

|---|---|

| 🚀 軽量動作 | VRAM 6GBでも動作可能(Stable Video Diffusion系に比べ非常に軽量) |

| 🎨 高品質な2Dアニメ風 | イラストベースで滑らかな動画が生成され、「ぬるぬる動く一枚絵」感が魅力 |

| 🧠 フレーム補間の工夫 | 特定の「流れ」に沿ってフレームを自動生成するため、省リソースで動画化が可能 |

現状の限界・制約

-

複数キャラの「独立した動き」が苦手

- 例:Aさんが歩いて、Bさんが手を振る → 同時に別の動作をさせると破綻しやすい

- なぜ? → 一貫性のある“主たる流れ”に沿った補間を前提としているため、個別の動きが干渉しやすい

-

背景やシーンの一貫性維持が難しい

- 例:猫が奥から横切っていく、背景で車が走る、などの非主役的な要素の動作が破綻しやすい

- なぜ? → 補間が視線誘導や主対象に最適化されており、副次的要素は省略またはランダム化されがち

-

連続カットの継ぎ目が不安定

- 例:数秒のアニメを複数つなげて構成したい場合、「位置」「姿勢」「方向」の継続性が切れやすい

- 特に、動画の切り替えポイントで違和感(ワープ、ブレ)が出やすい

逆に、だからこそできること

| 制約 | 活かし方 |

|---|---|

| 複雑な動きに弱い | → 1キャラ×明快なモーションを切り出して「キャラ演技」に特化 |

| シーン変化に弱い | → ループや1シーン短編として、短時間に集中した演出が得意 |

| リソース制限 | → VRAMが少ない環境でも生成可能(Colabや6GB GPUでOK) |

まとめ+今後の展望

FramePack‑eichiは「省リソース × キャラ中心の短尺アニメ」に特化したAI生成フレーム補間ツールです。

マルチキャラや背景の演出は苦手なので、シーンごとに分けて用途を割り切るのがベスト。

動作が軽く学習コストも低いため、アイデア出し・SNS用アニメ・演出のプロトタイプに向いています。

💬 コメント